使用场景

案例1: 使用Llama-Lynx-70b-4bit-Quantized开发一个客服聊天机器人,以自动回答客户咨询。

案例2: 利用该模型生成文章或博客内容,提高内容创作的效率。

案例3: 在教育领域,使用模型生成个性化的学习材料和练习题。

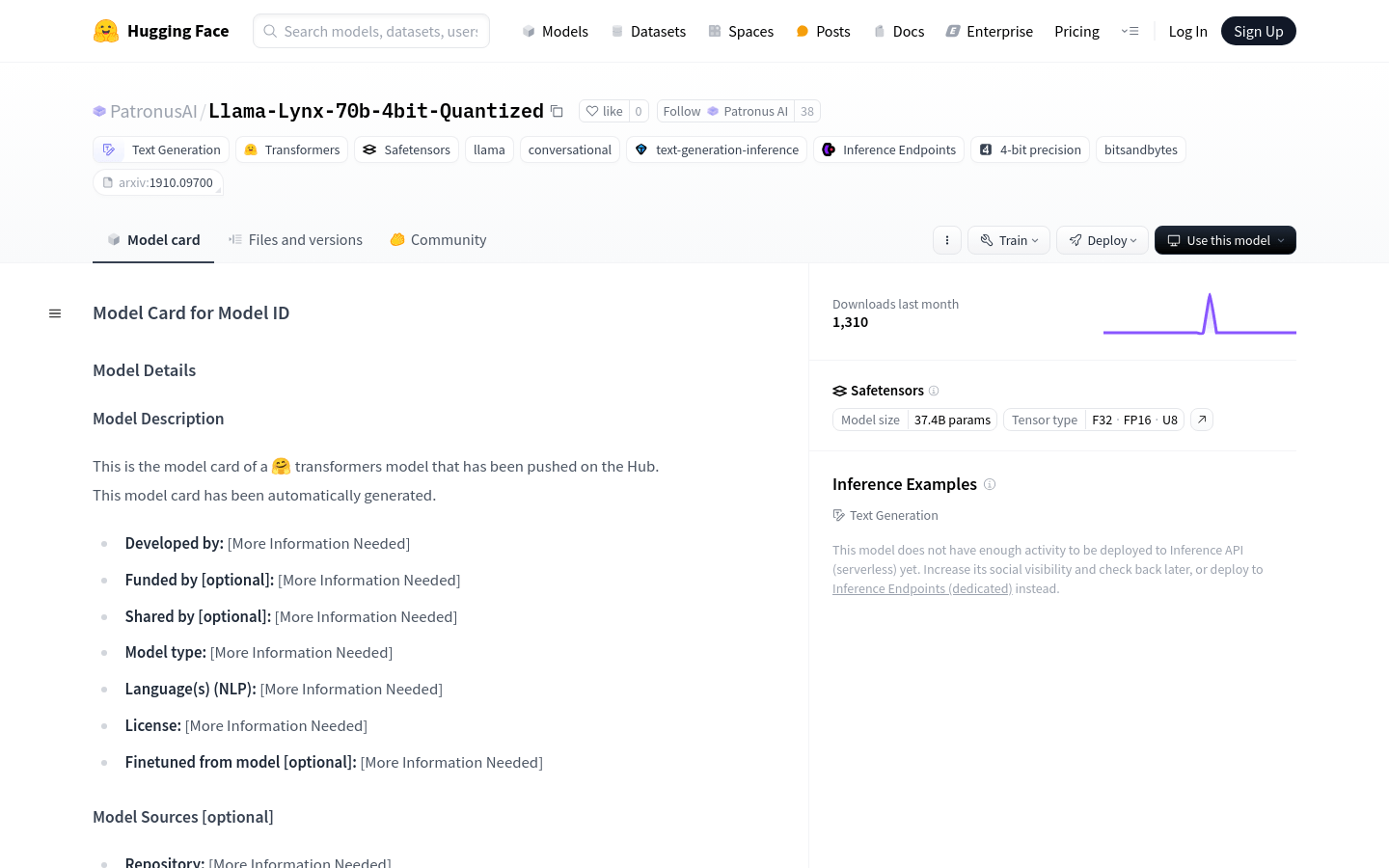

产品特色

• 文本生成:能够根据给定的提示生成连贯且相关的文本。

• 对话生成:适用于构建聊天机器人和对话系统,生成自然的对话回复。

• 多语言支持:模型支持多种语言,可以处理不同语言的文本生成任务。

• 4位量化:通过量化技术减少模型大小,提高推理速度,降低计算成本。

• 与Transformers库兼容:可以轻松集成到现有的基于Transformers的系统中。

• 模型卡和文件版本管理:提供模型卡和文件版本管理功能,方便追踪模型的变更和性能。

• 社区讨论:用户可以在Hugging Face社区中讨论模型的使用和改进。

使用教程

1. 访问Hugging Face官网并注册账号。

2. 导航至模型页面:https://huggingface.co/PatronusAI/Llama-Lynx-4bit-Quantized。

3. 阅读模型卡,了解模型的详细信息和使用条件。

4. 下载模型文件,并根据提供的指南进行本地部署或使用Hugging Face的Inference API进行部署。

5. 使用Python或其他支持的语言,编写代码以发送文本提示给模型,并接收生成的文本。

6. 根据需要调整模型参数,优化生成文本的质量。

7. 参与社区讨论,与其他开发者交流使用经验和最佳实践。