使用场景

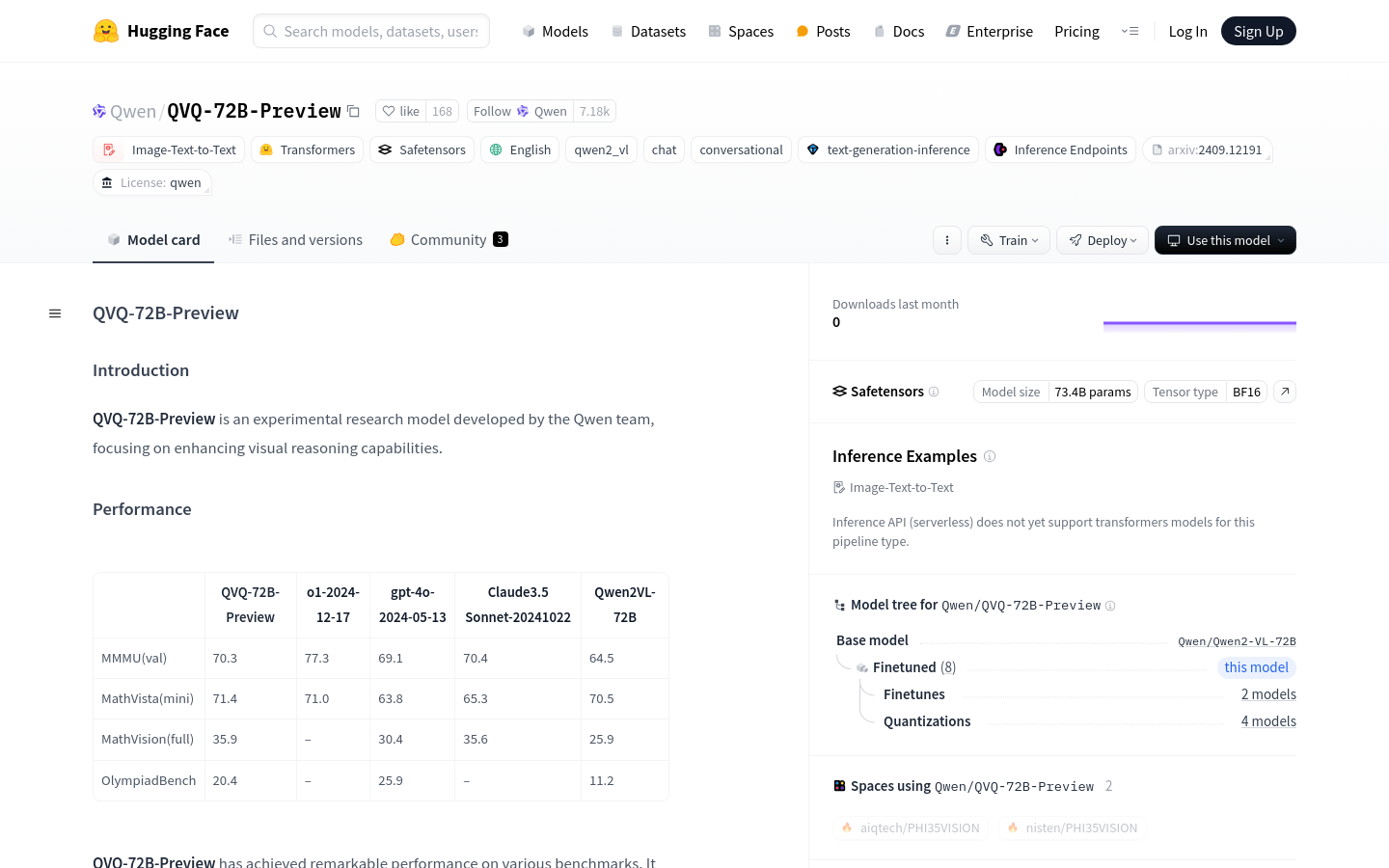

- 使用QVQ-72B-Preview模型在MMMU基准测试中进行多学科理解和推理任务。

- 利用模型在MathVision基准测试中处理数学推理任务。

- 在OlympiadBench上应用模型解决具有挑战性的问题。

产品特色

- 多学科理解和推理:在MMMU基准测试中得分高达70.3%,展现了强大的多学科理解和推理能力。

- 数学推理任务:在MathVision基准测试中取得显著进步,突出了模型在数学推理任务上的能力。

- 挑战性问题解决:在OlympiadBench上的表现也展示了模型解决挑战性问题的能力。

- 单轮对话支持:目前模型仅支持单轮对话和图像输出,不支持视频输入。

- 安全性和伦理考量:需要稳健的安全措施以确保可靠和安全的性能。

- 性能和基准限制:在多步视觉推理中可能会逐渐失去对图像内容的关注,导致幻觉。

- 基本识别任务:在识别人、动物或植物等基本任务上并没有显示出比Qwen2-VL-72B更显著的改进。

使用教程

1. 安装qwen-vl-utils工具包,以便更便捷地处理各种类型的视觉输入。

2. 使用transformers库加载Qwen2VLForConditionalGeneration模型。

3. 从qwen_vl_utils导入process_vision_info函数来处理视觉信息。

4. 准备输入消息,包括系统角色的消息和用户角色的消息,用户消息中包含图像和文本。

5. 使用processor.apply_chat_template函数准备推理所需的文本。

6. 调用process_vision_info函数处理视觉信息。

7. 将文本和视觉输入传递给processor,准备模型输入。

8. 使用model.generate函数生成输出。

9. 使用processor.batch_decode函数解码生成的ID,获取最终的输出文本。