使用场景

研究人员使用OpenEMMA在nuScenes数据集上测试新的自动驾驶算法。

开发者利用OpenEMMA提供的框架开发出自己的自动驾驶决策系统。

教育机构使用OpenEMMA作为教学工具,向学生展示自动驾驶技术的实际应用。

产品特色

• 利用预训练的视觉语言模型(VLMs)整合文本和视觉输入

• 精确预测自动驾驶车辆的未来路径点

• 提供模型决策的理由和解释

• 支持YOLO-3D等外部工具进行关键物体检测

• 支持多种模型,如GPT-4、LLaVA、Llama和Qwen2

• 生成预测路径的可视化图像和编译视频

• 支持nuScenes数据集进行模型训练和测试

使用教程

1. 设置Conda环境并激活:conda create -n openemma python=3.8; conda activate openemma

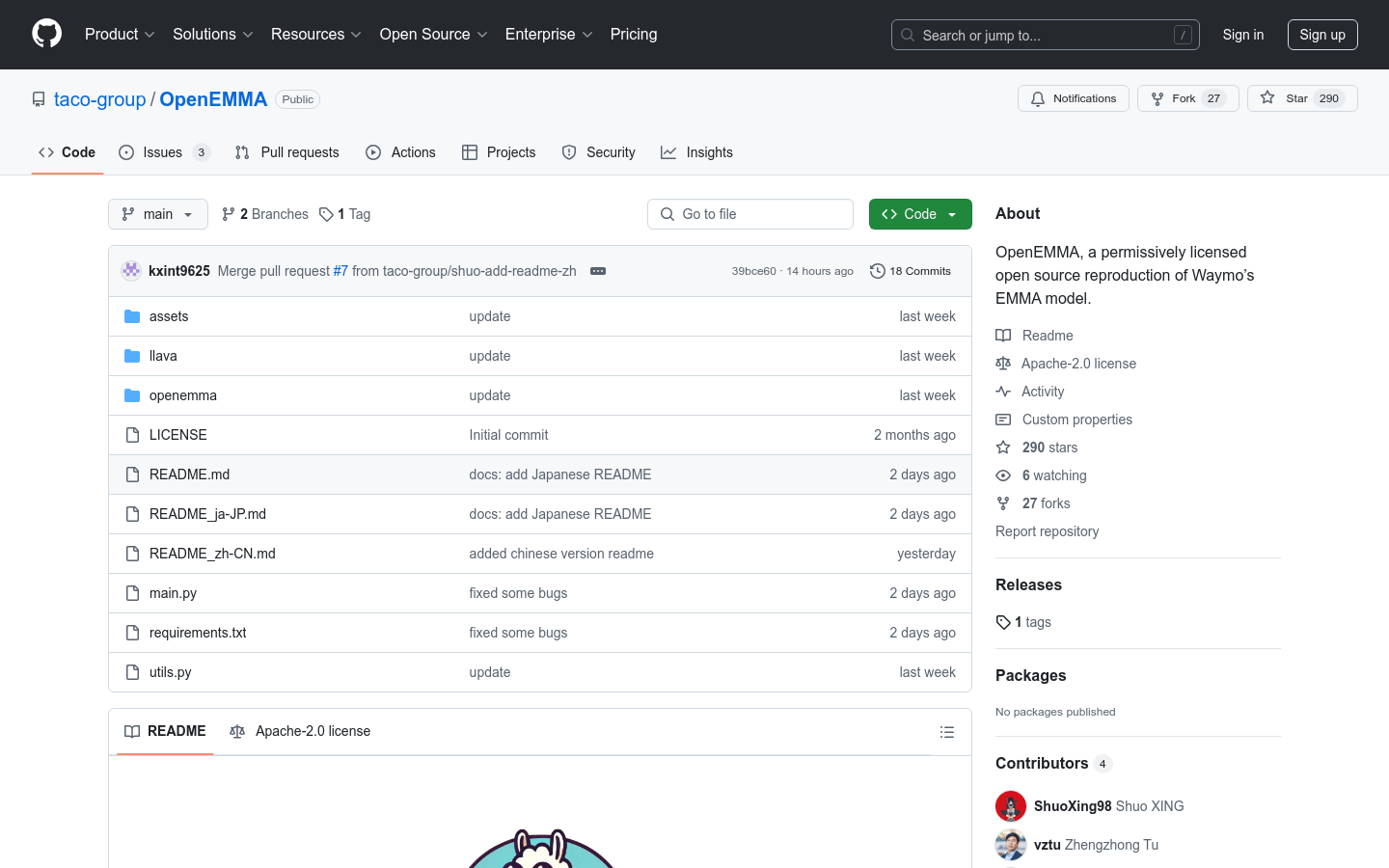

2. 克隆OpenEMMA仓库:git clone git@github.com:taco-group/OpenEMMA.git; cd OpenEMMA

3. 安装依赖:pip install -r requirements.txt

4. 设置GPT-4 API访问权限:export OPENAI_API_KEY="your_openai_api_key"

5. 准备输入数据:下载并解压nuScenes数据集

6. 运行OpenEMMA:python main.py --model-path [model] --dataroot [dataset_dir] --version [version] --method openemma

7. 解读输出:包括路径点、决策理由、标注图像和编译视频