使用场景

研究人员使用该模型进行跨语言的文本翻译和生成研究。

开发者利用模型的长上下文处理能力开发智能助手应用。

企业使用该模型优化客户服务中的自动回复系统。

产品特色

支持长达32K令牌的长上下文处理能力。

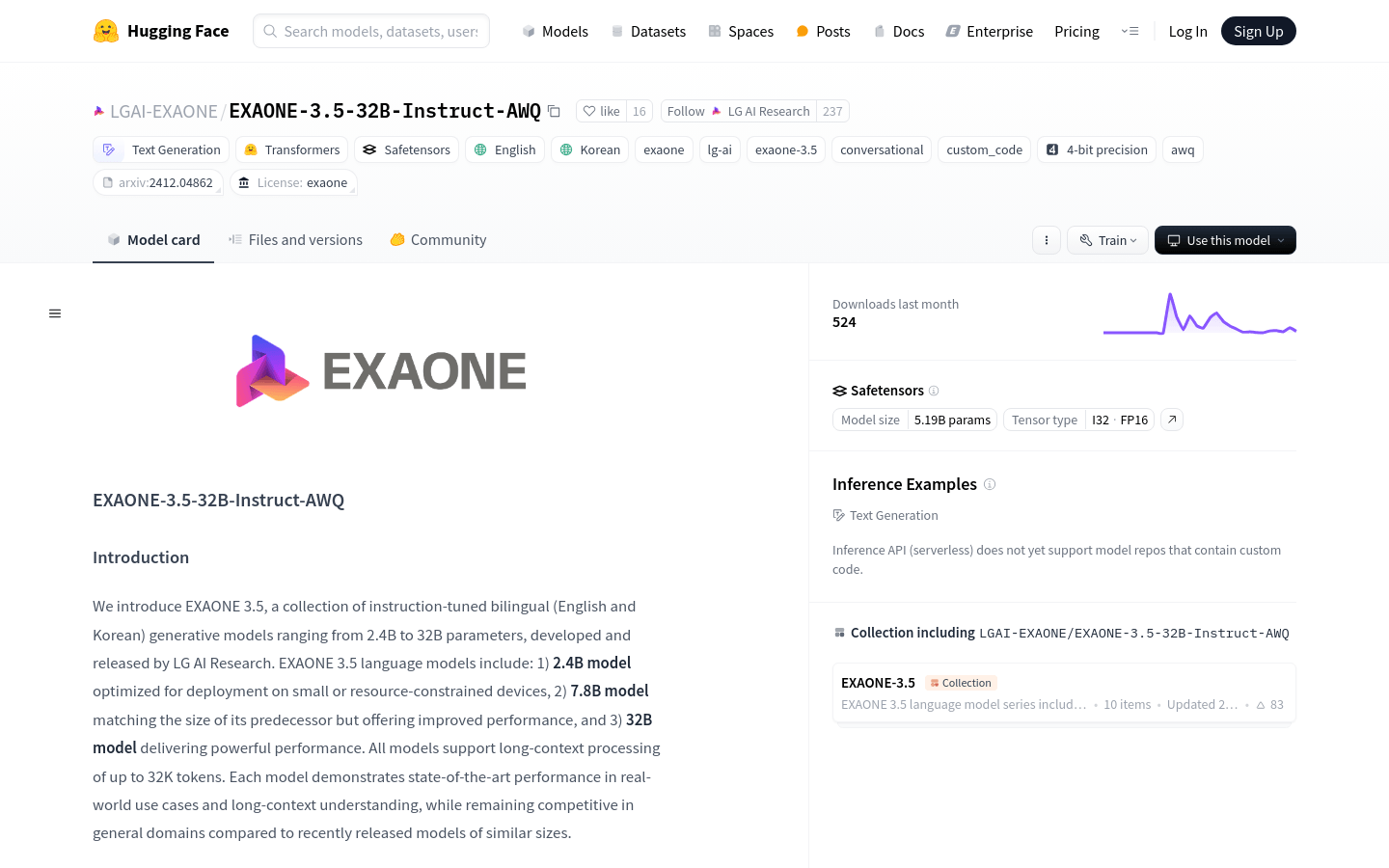

在英语和韩语的双语生成模型中展现出最先进的性能。

通过AWQ量化技术,实现了4位组级别的权重量化。

模型参数数量达到30.95B,拥有64层和40个查询头。

支持快速启动和部署,适用于多种框架,如TensorRT-LLM、vLLM等。

提供了预量化的EXAONE 3.5模型,方便在不同设备上部署。

模型生成的文本不反映LG AI Research的观点,确保内容的中立性。

使用教程

1. 安装必要的库,如transformers>=4.43和autoawq>=0.2.7.post3。

2. 使用AutoModelForCausalLM和AutoTokenizer从Hugging Face加载模型和分词器。

3. 准备输入提示,可以是英文或韩文。

4. 使用tokenizer.apply_chat_template方法将消息转换为模型输入格式。

5. 调用model.generate方法生成文本。

6. 使用tokenizer.decode方法将生成的令牌转换为可读文本。

7. 根据需要调整模型参数,如max_new_tokens和do_sample,以控制生成文本的长度和多样性。