使用场景

在大规模语料库中进行文本和代码的语义搜索。

用于长文档的检索和分类任务。

在代码搜索和StackQA等代码检索任务中达到新的最佳性能。

产品特色

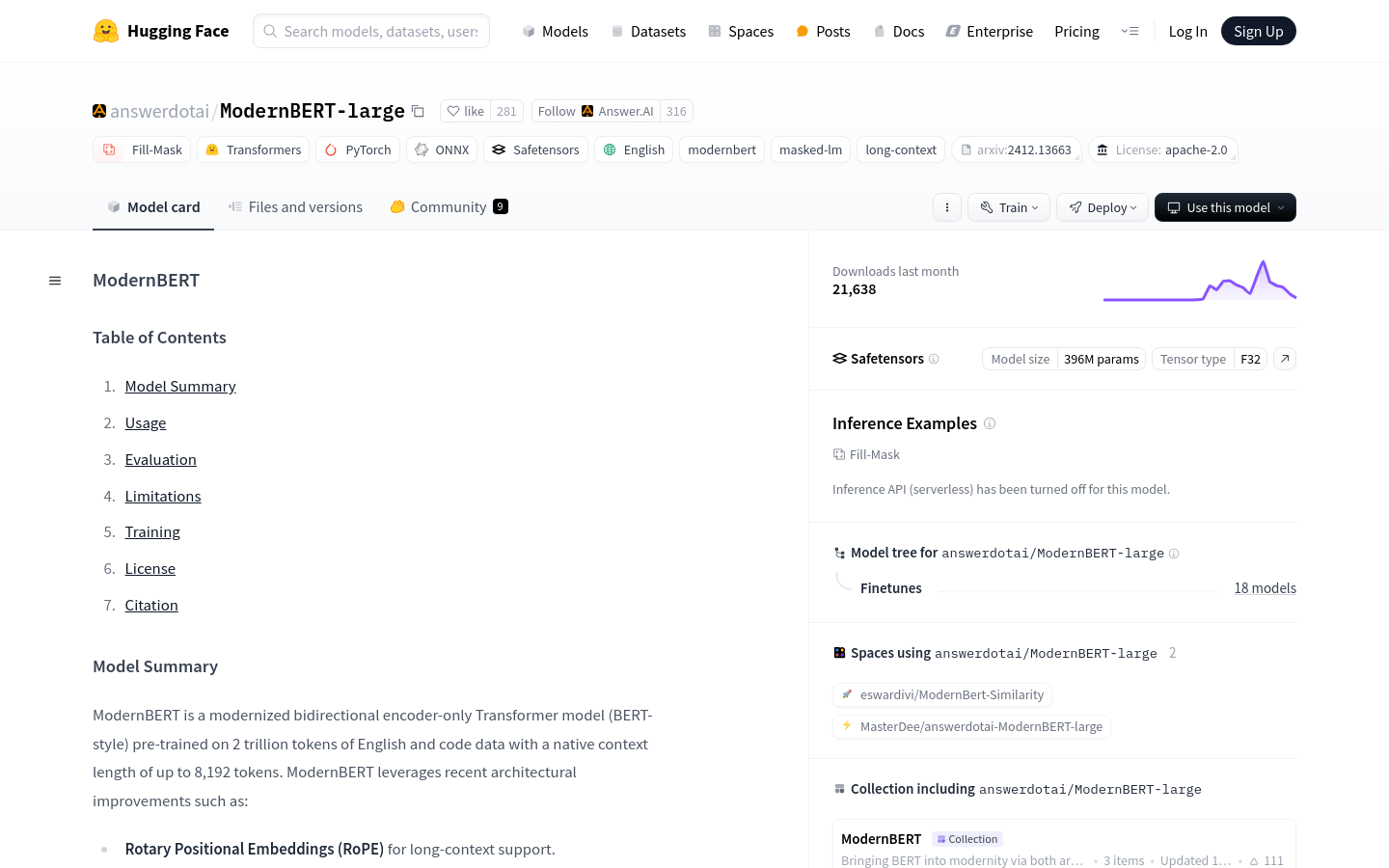

• 旋转位置嵌入(RoPE):支持长上下文处理。

• 局部-全局交替注意力:提高长输入的处理效率。

• 无填充和Flash Attention:提高模型推理效率。

• 长上下文长度:原生支持长达8192个token的上下文。

• 多任务适用:适用于文本和代码的检索、分类和语义搜索。

• 高性能:在多个任务上超越其他相似大小的编码器模型。

• 预训练数据丰富:基于2万亿个英文和代码数据预训练。

使用教程

1. 安装transformers库:使用pip安装最新的transformers库。

2. 加载模型和分词器:使用AutoTokenizer和AutoModelForMaskedLM从预训练模型加载分词器和模型。

3. 输入文本处理:将输入文本通过分词器处理,得到模型需要的输入格式。

4. 模型推理:将处理后的输入文本传递给模型,进行推理。

5. 获取预测结果:从模型输出中获取预测结果,例如填充[mask]的预测词。

6. 微调模型:根据下游任务对模型进行微调,以提高特定任务的性能。