使用场景

在制作虚拟主播视频时,使用 LatentSync 可以根据主播的语音自动生成逼真的唇部动作,提高视频的真实感和互动性。

动画制作公司可以利用 LatentSync 为角色配音时自动生成匹配的唇部动画,节省传统手动制作唇部动画的时间和成本。

影视特效团队在制作特效视频时,可以借助 LatentSync 修复或增强视频中人物的唇部同步效果,提升整体视觉效果。

产品特色

音频条件的潜在扩散模型:利用 Stable Diffusion 直接建模音视频关联,无需中间运动表示

时间表示对齐(TREPA):通过大规模自监督视频模型提取的时间表示,增强生成视频帧的时间一致性

唇部同步准确性高:通过 SyncNet 损失等优化手段,确保生成视频的唇部同步效果

数据处理流程完善:提供完整的数据处理脚本,涵盖视频修复、帧率重采样、场景检测、面部检测与对齐等步骤

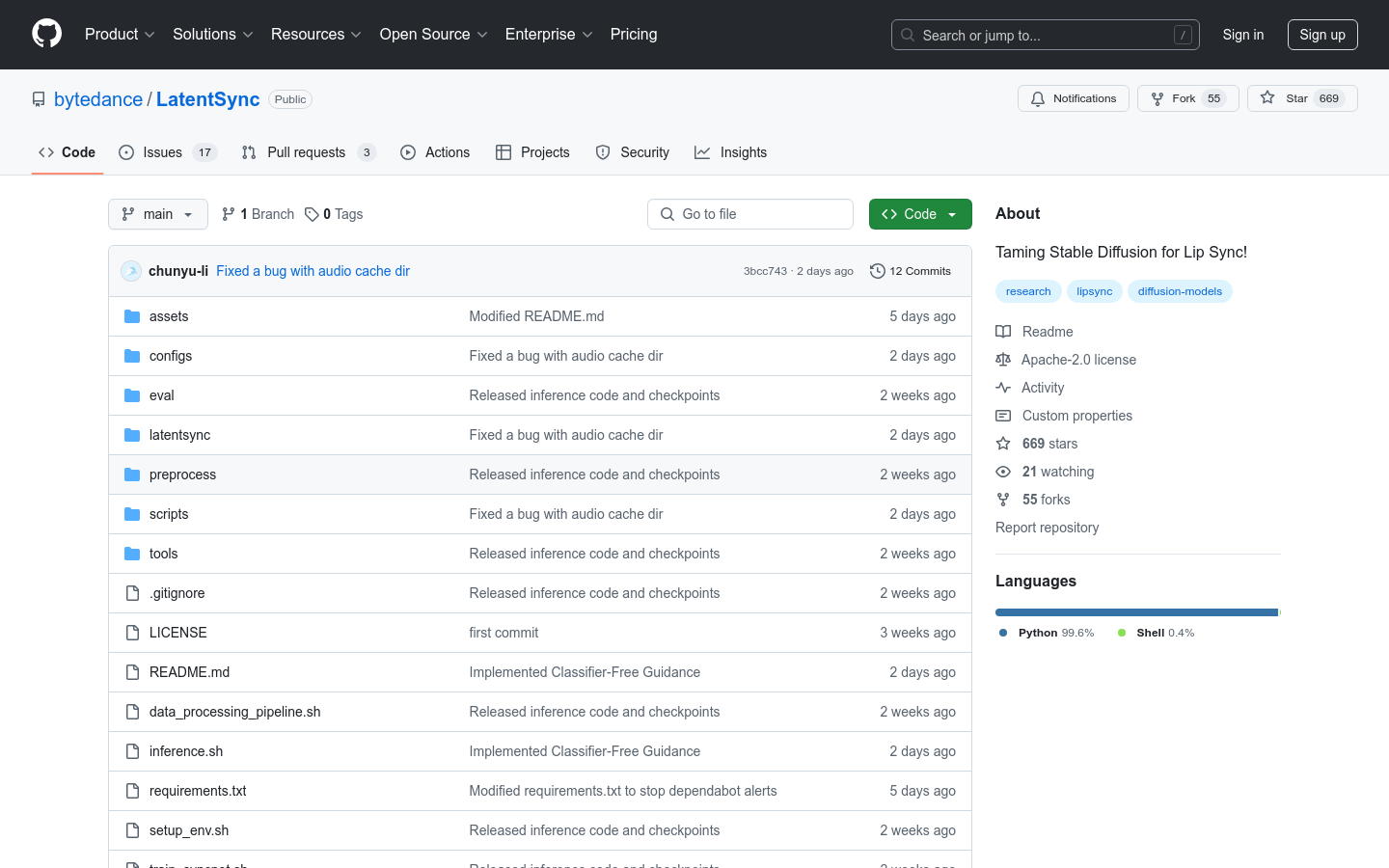

训练与推理代码开源:包括 U-Net 和 SyncNet 的训练脚本,以及推理脚本,方便用户进行模型训练和应用

模型检查点提供:开源模型的检查点文件,方便用户快速下载和使用

支持多种视频风格:能够处理真实视频和动漫视频等不同风格的视频素材

使用教程

1. 环境准备:安装所需依赖包,下载模型检查点文件,具体步骤为运行 setup_env.sh 脚本。

2. 数据处理:使用 data_processing_pipeline.sh 脚本对视频数据进行预处理,包括视频修复、帧率重采样、场景检测、面部检测与对齐等。

3. 模型训练:如果需要训练模型,可以分别运行 train_unet.sh 和 train_syncnet.sh 脚本进行 U-Net 和 SyncNet 的训练。

4. 推理使用:运行 inference.sh 脚本进行唇部同步视频的生成,可以根据需要调整 guidance_scale 参数以提高唇部同步的准确性。

5. 结果评估:对生成的唇部同步视频进行评估,检查唇部动作与语音的匹配程度,以及视频的整体质量和效果。