使用场景

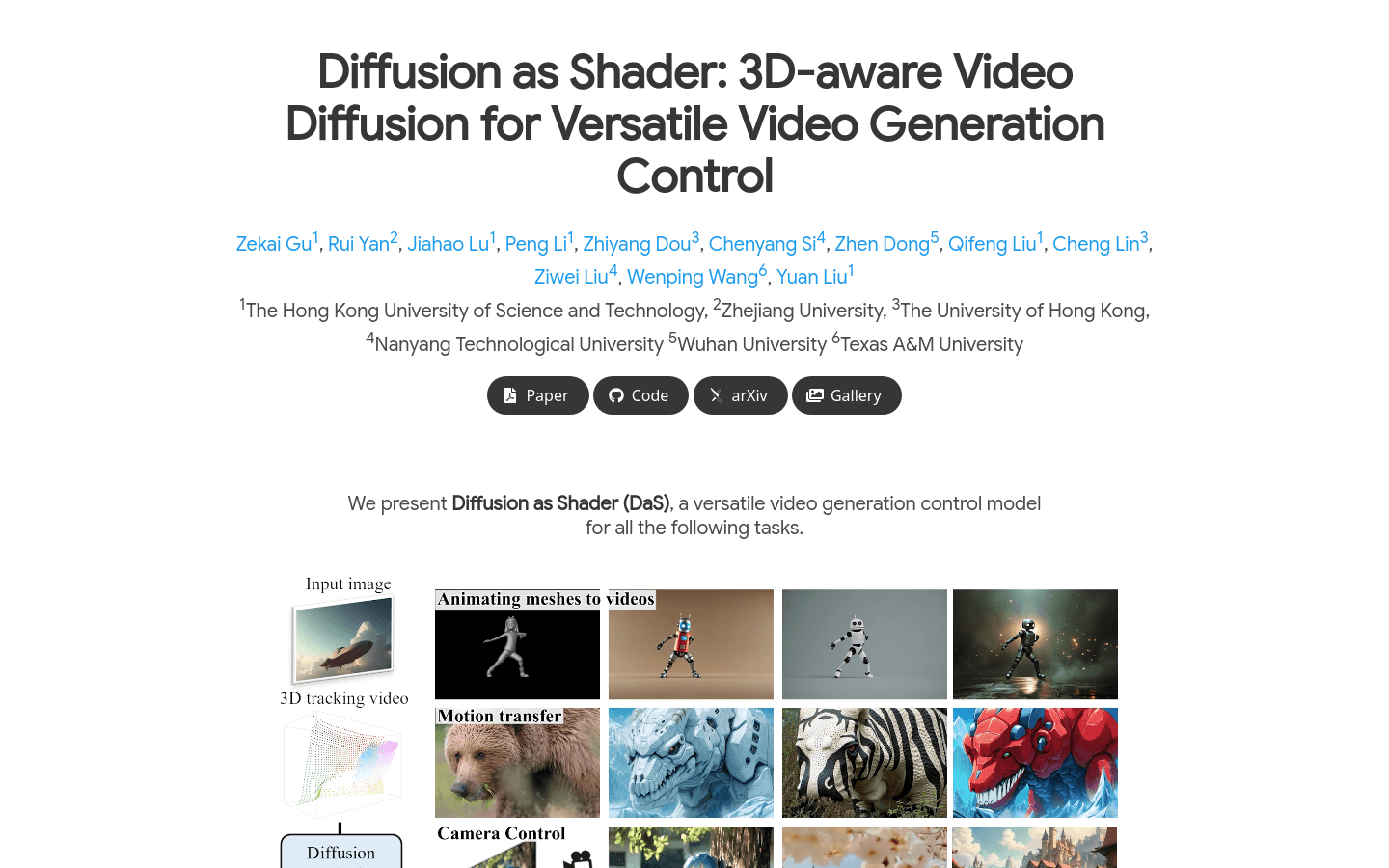

将一个简单的动画网格转换为具有详细外观和几何特征的高质量视频。

根据给定的文字提示,生成一段具有特定相机运动轨迹的视频。

将一个视频中的运动转移到另一个视频中,实现运动迁移。

对视频中的特定对象进行操作,如移动、旋转等,以满足特定的视频制作需求。

产品特色

支持从文本提示或图像生成高质量视频

实现精确的相机控制,如上下左右移动和螺旋运动

能够将简单的动画网格转换为视觉丰富的视频

支持对象操作,如对特定对象进行移动、旋转等操作

实现运动迁移,将一个视频中的运动转移到另一个视频中

通过3D跟踪视频增强生成视频的时间一致性

在少量数据和短时间内即可完成模型微调

使用教程

1. 准备输入数据,如文本提示、图像或简单的动画网格。

2. 使用DaS模型提供的工具(如Depth Pro、SAM等)对输入数据进行预处理,如估计深度图、分割对象等。

3. 根据需要生成3D跟踪视频,作为视频生成的控制输入。

4. 将预处理后的数据和3D跟踪视频输入到DaS模型中,进行视频生成。

5. 微调模型参数以优化生成视频的质量和控制效果。

6. 输出生成的视频,进行后续的编辑和应用。