使用场景

视频创作者可以利用该项目将特定人物的照片融入视频,为视频添加独特的风格和身份特征。

研究人员可以基于该项目的模型和代码,进一步探索视频扩散变换器在视频定制化中的应用和优化。

开发者可以将该项目的模型集成到自己的视频编辑软件中,为用户提供个性化的视频创作功能。

产品特色

提供简单的测试脚本infer.py,方便用户进行推理测试。

包含评估指标代码和评估数据,用于多ID定制任务的结果比较。

对提示词质量有较高要求,建议参考相关链接以提高生成效果。

支持通过Gradio Web UI进行在线演示,整合了当前支持的所有功能。

即将推出多阶段训练脚本和多ID文本-视频数据集,以支持进一步的训练和研究。

使用教程

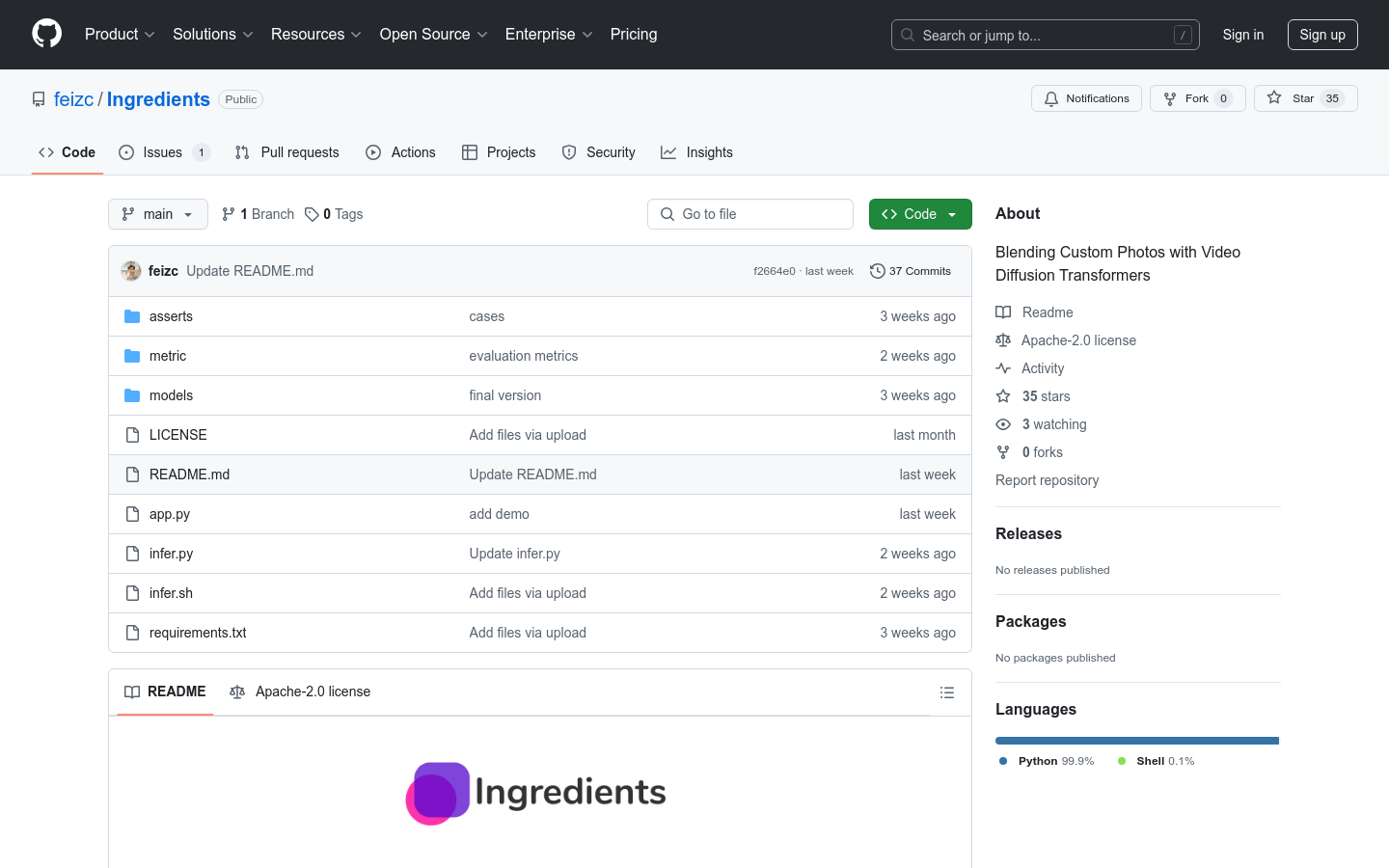

1. 克隆该项目的GitHub仓库到本地。

2. 根据README中的环境配置要求,创建并激活conda环境,安装依赖。

3. 下载模型权重文件,放置在指定路径。

4. 使用infer.py脚本,输入提示词、模型路径、种子值和图片文件路径,进行推理测试。

5. 查看生成的视频结果,根据需要调整提示词和其他参数以优化结果。

6. 尝试使用Gradio Web UI进行在线演示,体验项目支持的全部功能。

7. 对于有训练需求的用户,等待项目发布多阶段训练脚本和数据集,按照指引进行训练。