使用场景

在教育领域,教师可以利用其多模态直播功能进行在线教学,实时与学生互动。

在商业会议中,参与者可以通过语音对话功能进行远程交流,提高会议效率。

在内容创作方面,创作者可以利用其图像和视频理解能力,生成相关的文字描述或创意内容。

产品特色

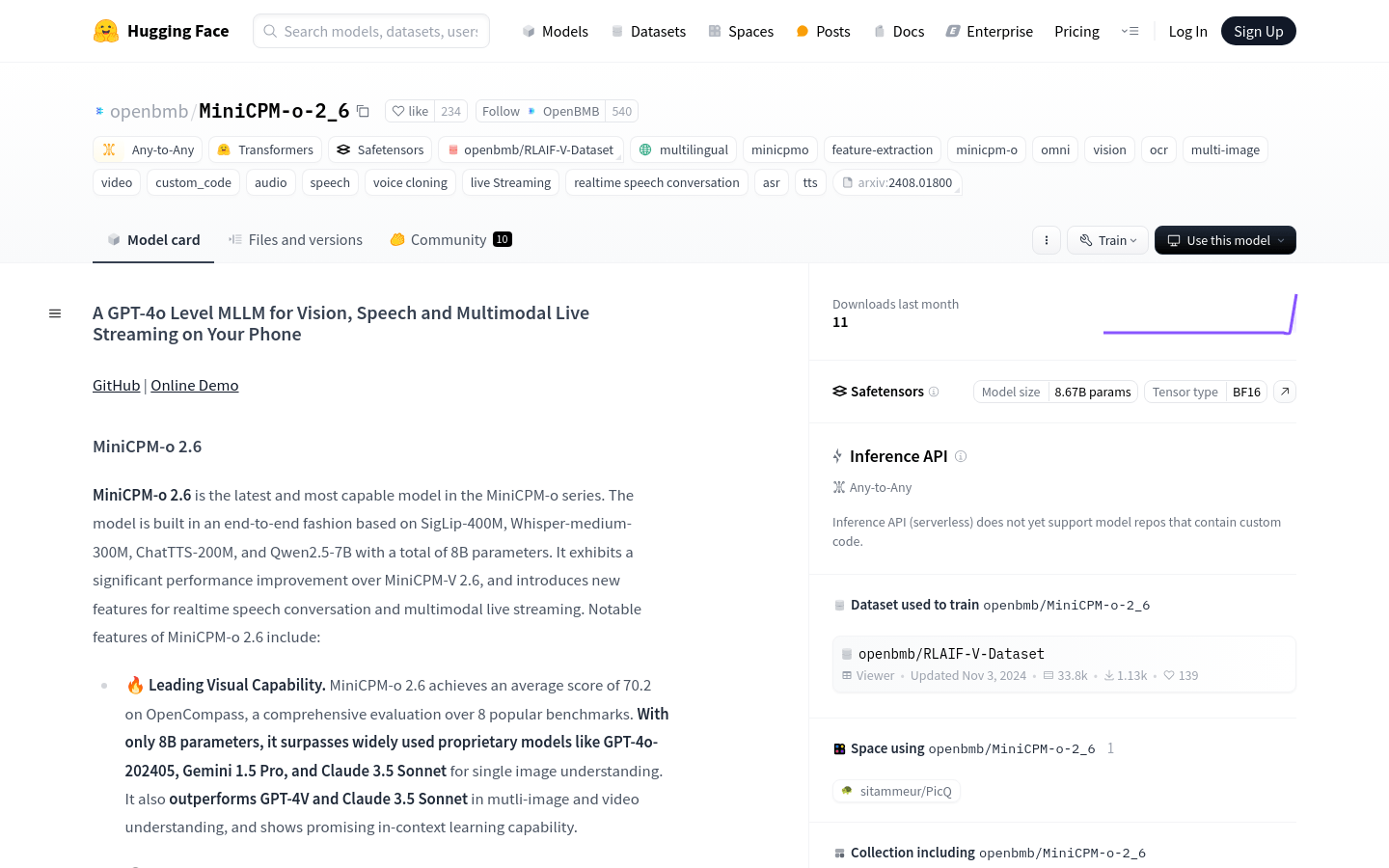

领先的视觉能力,在OpenCompass上平均得分70.2,超越多个知名模型。

支持双语实时语音对话,可配置声音,支持情感/速度/风格控制等功能。

强大的多模态直播能力,可接受连续视频和音频流,支持实时语音交互。

先进的OCR能力,可处理任意宽高比和高达180万像素的图像。

高效的推理速度和低延迟,适用于终端设备上的多模态直播。

易于使用,支持多种使用方式,包括llama.cpp、int4和GGUF格式量化模型、vLLM等。

使用教程

1. 使用Hugging Face Transformers在NVIDIA GPU上进行推理,安装所需库。

2. 加载模型和分词器,初始化模型的视觉、音频和TTS部分。

3. 根据需要选择全模态、视觉模态或音频模态进行推理。

4. 准备输入数据,如图像、视频、音频等,并进行预处理。

5. 调用模型的chat方法进行推理,获取输出结果。

6. 根据需要保存生成的音频或文本结果。