使用场景

视频内容创作者可以使用 Tarsier 自动生成视频的详细描述,节省时间和精力。

研究人员可以利用 Tarsier 的模型架构和训练方法进行视频语言模型的研究和改进。

视频平台可以集成 Tarsier 提供自动视频描述功能,提升用户体验和内容可访问性。

产品特色

生成高质量视频描述,能够详细描述视频中的事件、动作和场景。

支持多任务预训练,涵盖视频描述、视频问答等多种任务。

采用多粒度指令微调,提升模型对不同复杂度视频的理解能力。

在多个视频理解基准测试中取得 SOTA 结果,包括 MVBench、NeXT-QA 等。

提供 DREAM-1K 视频描述基准测试数据集,用于评估模型性能。

支持多种输入格式,包括视频、图像和 GIF 文件。

提供在线演示和开源代码,方便开发者进行研究和部署。

使用教程

1. 创建 Python 3.9 的虚拟环境(如果尚未安装):`conda create -n tarsier python=3.9`

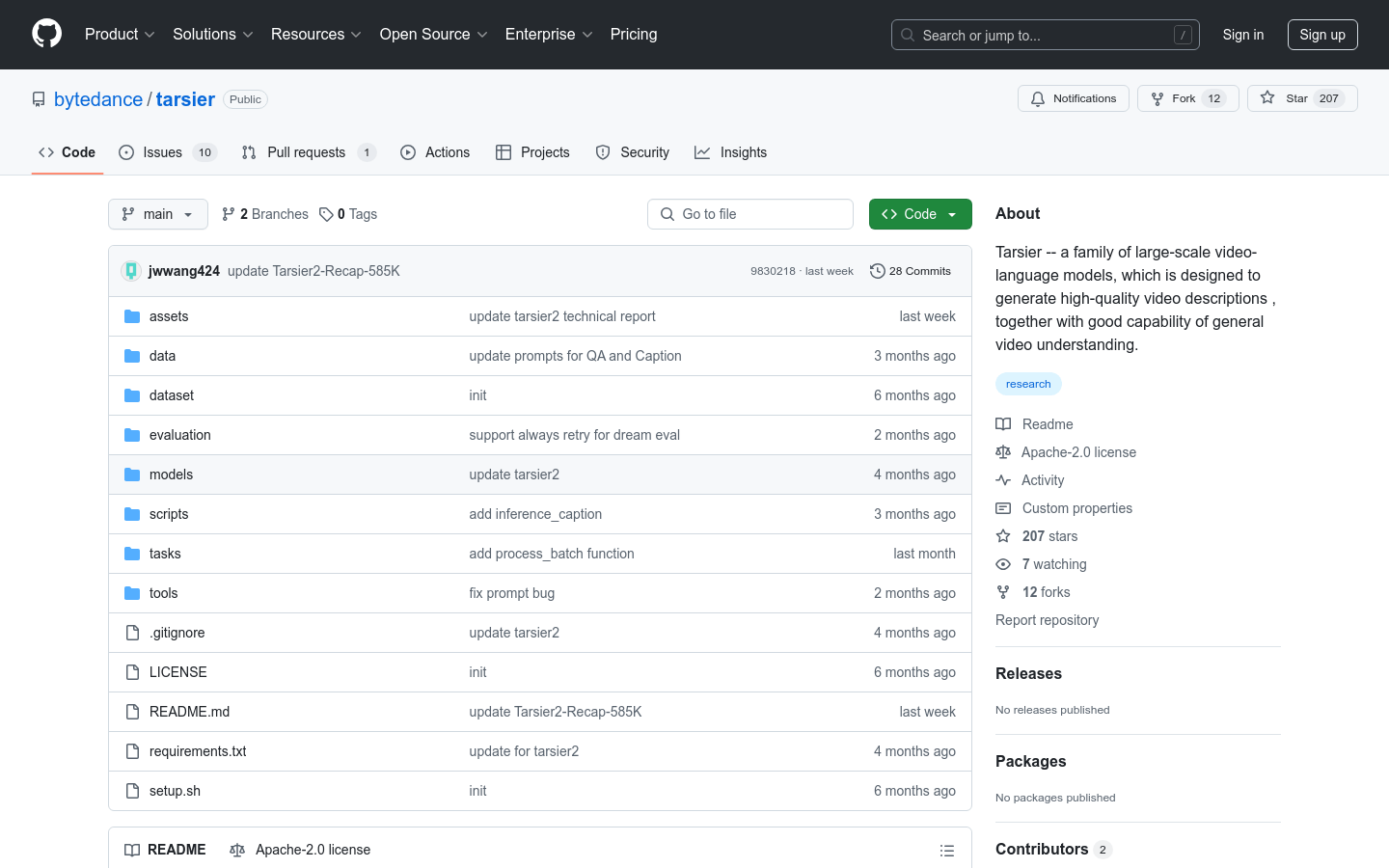

2. 克隆 Tarsier 代码仓库:`git clone https://github.com/bytedance/tarsier.git`

3. 进入项目目录并运行安装脚本:`cd tarsier && bash setup.sh`

4. 下载模型权重文件,可以从 Hugging Face 获取:`Tarsier-7b` 或 `Tarsier-34b`

5. 准备输入视频文件,例如 `assets/videos/coffee.gif`

6. 运行快速启动脚本生成视频描述:`python3 -m tasks.inference_quick_start --model_name_or_path <模型路径> --instruction 'Describe the video in detail.' --input_path <视频路径>`