使用场景

使用 SFT 方法对模型进行微调,以适应特定的自然语言处理任务。

通过 GRPO 方法优化模型性能,提高模型在推理任务中的表现。

利用 Distilabel 生成合成数据,增强模型的泛化能力。

产品特色

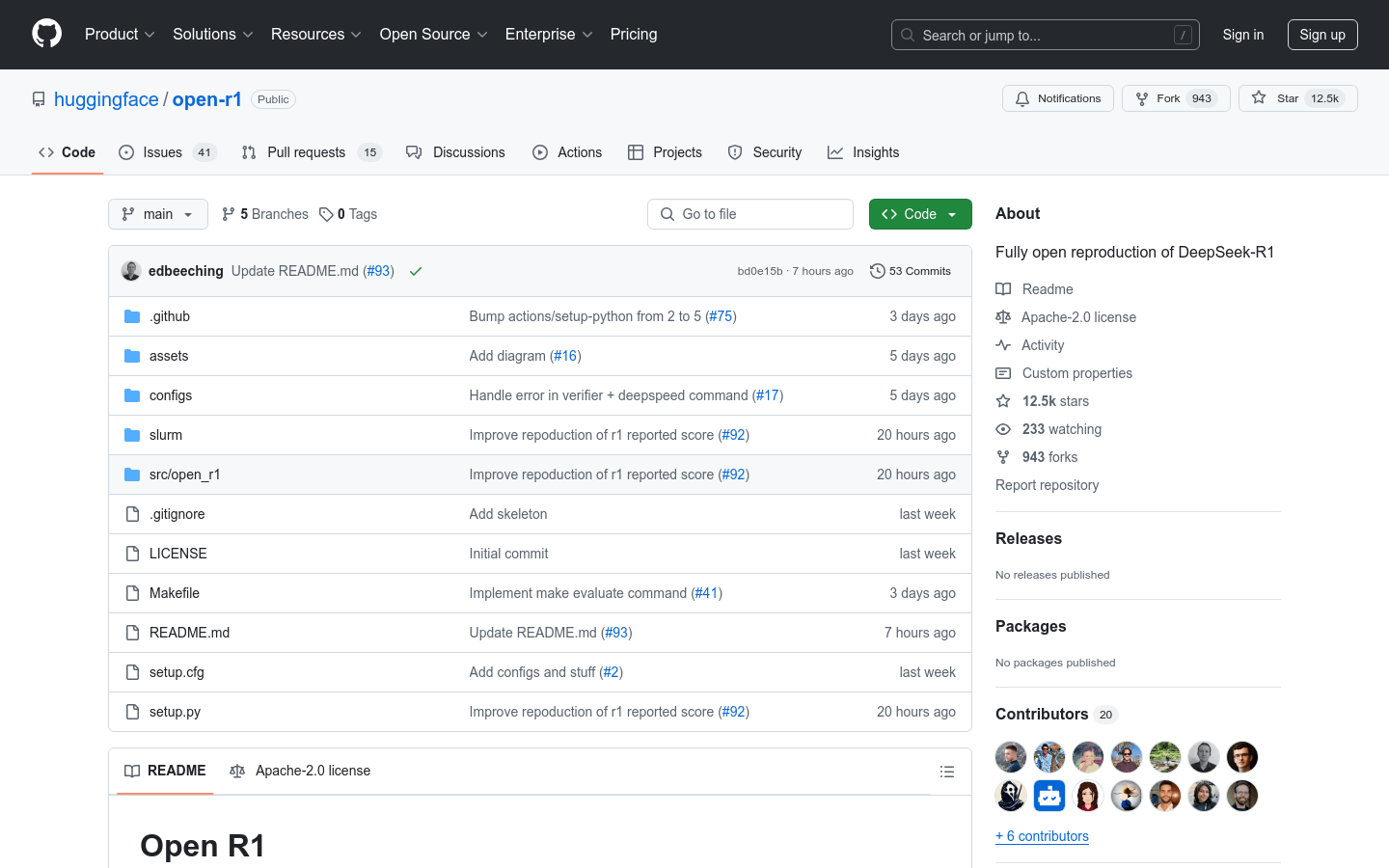

提供完整的 R1 模型训练和评估流程,包括 SFT 和 GRPO 方法。

支持多种硬件配置,如 DDP 和 DeepSpeed(ZeRO-2 和 ZeRO-3)。

通过 Distilabel 生成合成数据,丰富训练数据集。

使用 lighteval 进行模型评估,支持多种任务和模型大小。

提供 Makefile 简化命令操作,方便用户快速上手。

使用教程

1. 创建 Python 虚拟环境并安装必要的依赖项,如 vLLM 和 PyTorch。

2. 下载项目代码并配置加速器配置文件。

3. 使用 SFT 或 GRPO 脚本训练模型,根据需要调整参数。

4. 使用 lighteval 工具评估模型性能,选择合适的任务和模型配置。

5. 通过 Makefile 命令简化操作流程,快速执行训练和评估任务。