使用场景

研究人员使用该模型进行大规模语言模型的预训练,以提升模型性能。

企业利用该技术在AMD GPU集群上优化语言模型的训练流程,降低计算成本。

开发者基于该代码库开发定制化的语言模型,用于特定领域的文本生成任务。

产品特色

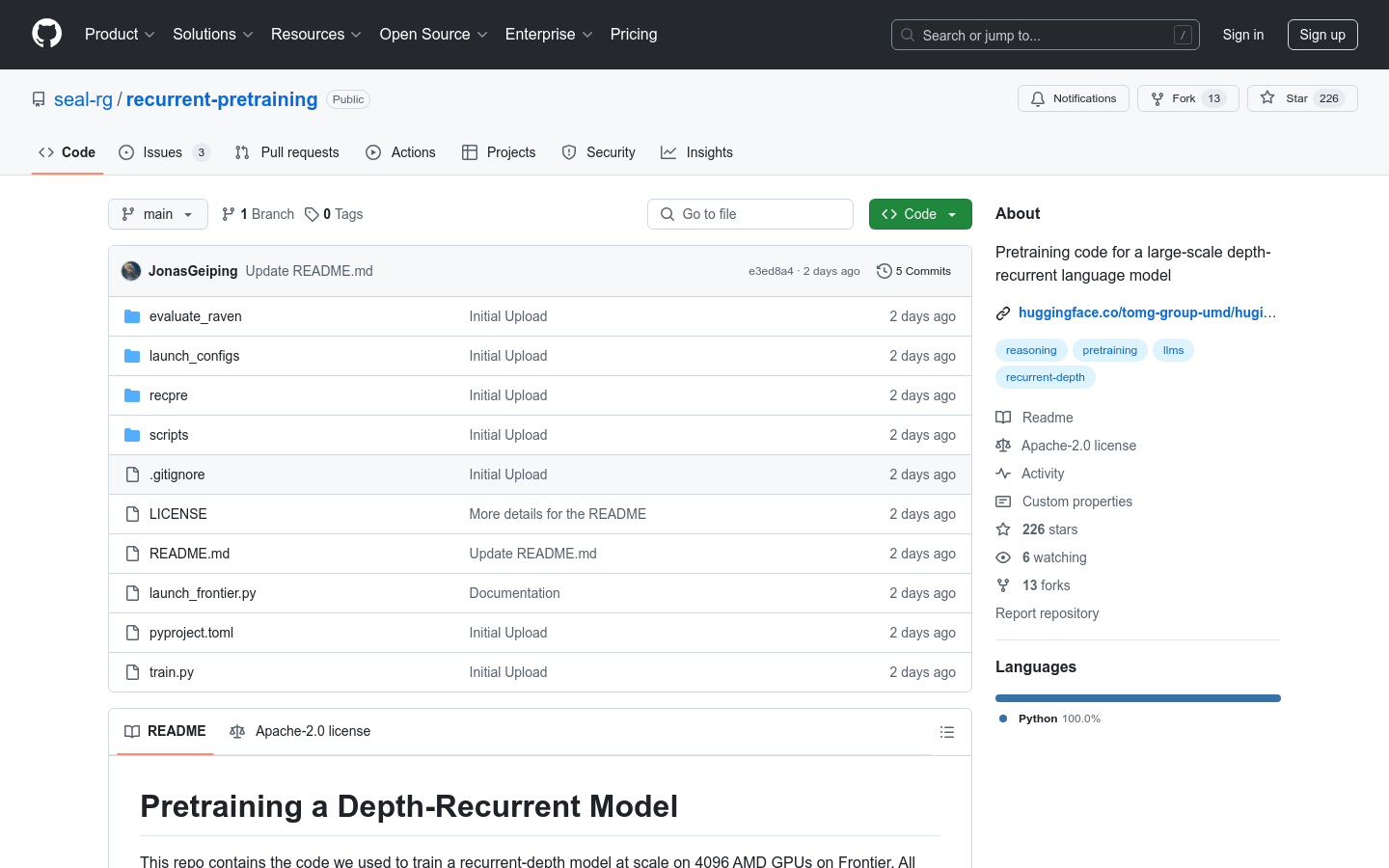

支持大规模分布式训练,可在4096个AMD GPU上运行

深度循环架构,提升模型推理能力

优化的通信机制,解决大规模训练中的通信瓶颈

完整的预训练流程,包括数据准备和模型评估

基于PyTorch开发,易于扩展和修改

提供详细的训练配置和环境设置说明

使用教程

1. 克隆代码库到本地环境。

2. 根据文档配置环境,包括安装依赖和设置环境变量。

3. 准备训练数据,使用`scripts/`中的脚本进行数据预处理。

4. 修改`launch_configs/`中的配置文件以适配你的硬件环境。

5. 运行`train.py`启动训练过程。

6. 使用`evaluate_raven/`中的脚本对训练好的模型进行评估。

7. 根据需要调整模型架构或训练参数以优化性能。