使用场景

在处理长文档生成任务时,MoBA 能够高效地提取关键信息并生成连贯的文本。

用于代码生成任务,MoBA 可以快速理解上下文并生成高质量代码。

在长文本问答系统中,MoBA 能够快速定位关键信息,提高回答的准确性和效率。

产品特色

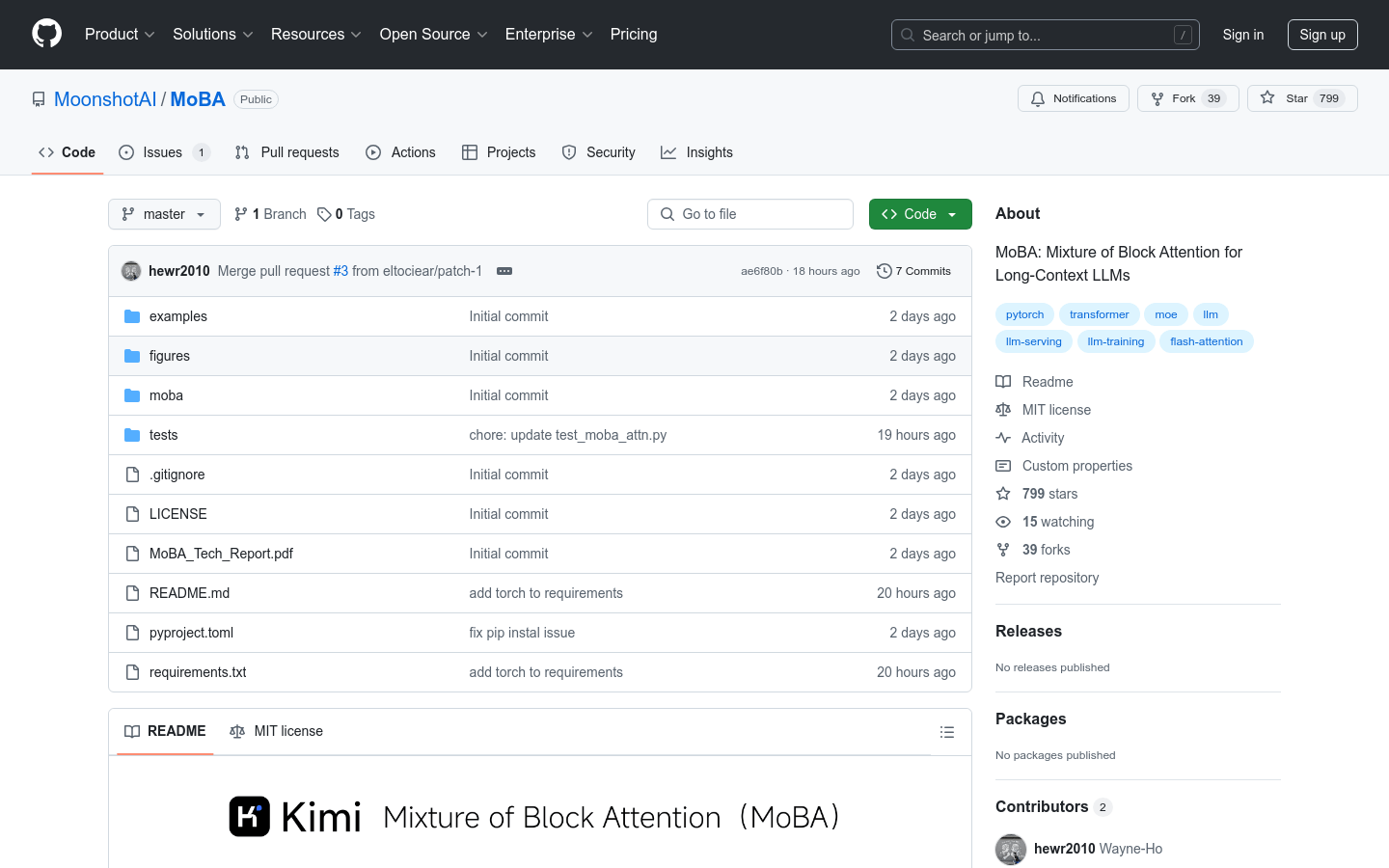

可训练的块稀疏注意力机制,高效处理长序列

无参数的 Top-k 门控机制,选择最相关的块

无缝切换全注意力和稀疏注意力模式

与现有 Transformer 架构兼容,易于集成

支持 1M 长上下文的高效计算

提供 PyTorch 实现,便于开发者使用

支持 Flash Attention,进一步优化性能

提供详细的文档和示例代码,方便上手

使用教程

1. 创建 Python 虚拟环境并安装依赖:`conda create -n moba python=3.10`,激活环境后运行 `pip install .`。

2. 使用 MoBA 替代传统注意力机制:在代码中指定 `--attn moba` 参数。

3. 运行示例代码:`python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba`。

4. 使用单元测试验证 MoBA 的正确性:运行 `pytest tests/test_moba_attn.py`。

5. 根据需求调整 MoBA 的参数,如块大小和稀疏度,以优化性能。