使用场景

研究人员可以使用该排行榜来比较不同LLM模型在生成总结时的幻觉率,从而选择更可靠的模型。

开发者可以利用该工具评估自己开发的LLM模型性能,优化模型以减少幻觉产生。

企业可以参考该排行榜选择适合其业务需求的LLM模型,用于内容生成、客服等场景。

产品特色

提供基于HHEM-2.1模型的LLM幻觉评估

支持多种LLM的比较和排名

使用CNN/Daily Mail语料库进行文档总结测试

通过API调用各种LLM模型进行评估

提供幻觉率、事实一致性率和回答率等关键指标

支持多语言模型的评估(目前主要支持英文)

定期更新以反映模型性能的变化

使用教程

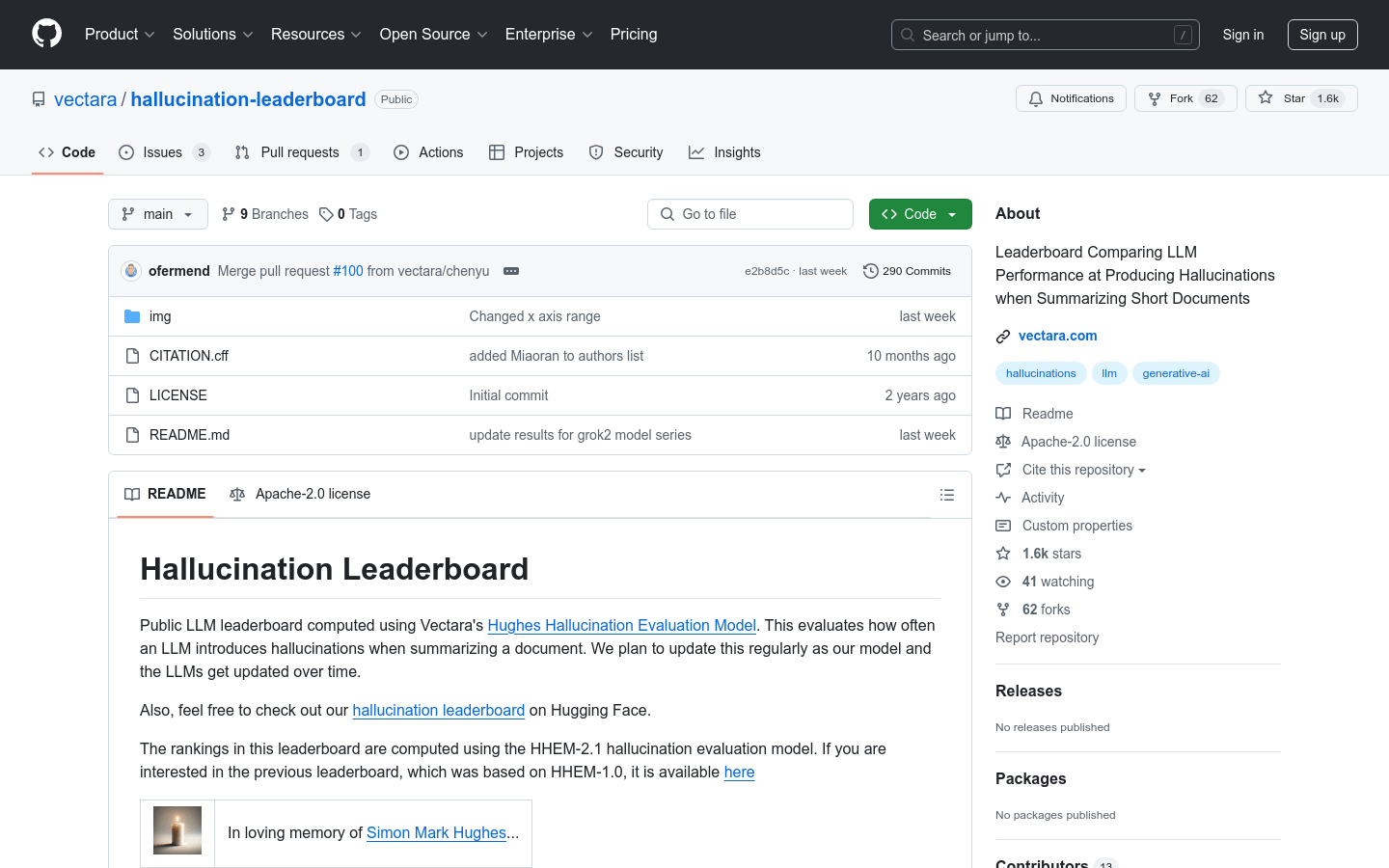

1. 访问项目主页(https://github.com/vectara/hallucination-leaderboard),了解项目背景和使用方法。

2. 查看README文件,了解如何使用HHEM-2.1模型进行评估。

3. 准备需要评估的LLM模型及其API接口。

4. 使用项目提供的脚本或代码,调用LLM模型生成总结。

5. 通过HHEM-2.1模型评估生成的总结,获取幻觉率等指标。

6. 分析评估结果,比较不同模型的性能。

7. 根据需要调整模型或选择更优的模型进行应用。