使用场景

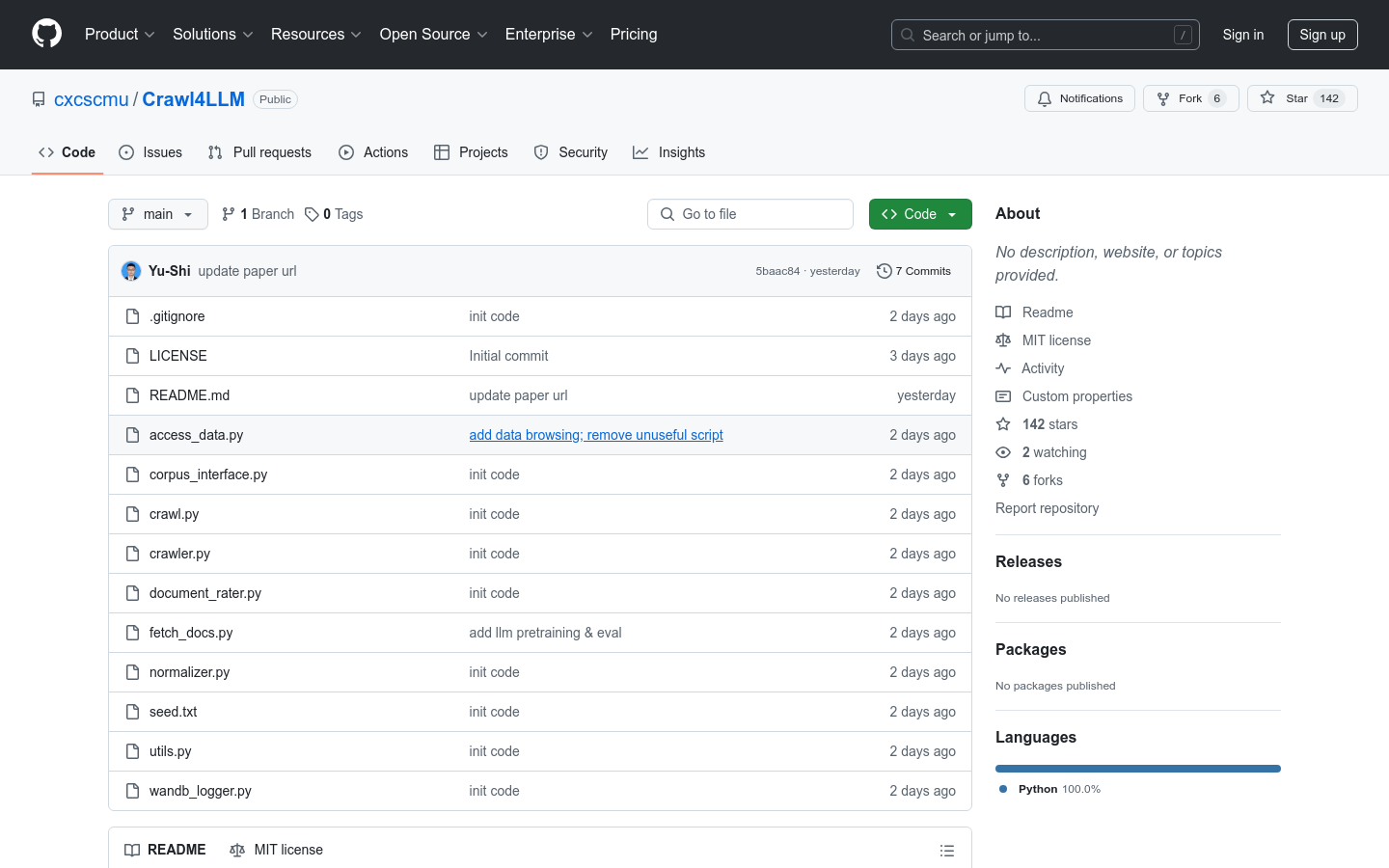

研究人员使用Crawl4LLM从ClueWeb22数据集中爬取高质量文档,用于LLM的预训练。

开发者利用Crawl4LLM的灵活配置,自定义爬取策略,以满足特定项目的预训练需求。

团队通过Crawl4LLM高效爬取数据,并结合DCLM框架进行模型评估和优化。

产品特色

支持多种文档评分方法,如基于长度、基于fastText模型评分等

灵活的配置选项,允许用户自定义爬取策略和参数

高效的数据爬取能力,支持多线程和大规模数据处理

与DCLM框架集成,便于后续的LLM预训练和评估

支持从ClueWeb22等大规模数据集中爬取数据

提供日志记录和状态保存功能,方便监控和恢复爬取过程

支持随机、基于入度等多种基线爬虫策略

使用教程

1. 请求ClueWeb22数据集并准备Python虚拟环境。

2. 安装项目依赖,包括numpy、tqdm、fasttext等。

3. 下载DCLM fastText分类器到指定目录。

4. 创建配置文件,设置爬取参数和策略。

5. 运行crawl.py脚本开始爬取数据。

6. 使用fetch_docs.py获取爬取的文档文本。

7. 结合DCLM框架进行LLM预训练和评估。