使用场景

在自动驾驶场景中,VLM-R1 可以用于理解交通标志和道路状况的描述。

在智能客服中,该模型可以解析用户对商品图片的描述,提供精准的客服支持。

在图像标注任务中,VLM-R1 能够根据自然语言描述快速定位图像中的目标对象。

产品特色

支持指代表达理解任务,能够准确识别图像中的特定对象。

提供 GRPO(Guided Reinforcement Policy Optimization)训练方法,提升模型的泛化能力。

兼容多种数据格式,支持自定义数据加载和处理。

提供详细的训练和评估脚本,方便用户快速上手和扩展。

支持多种硬件加速选项,如 BF16 和 Flash Attention 2,优化训练效率。

使用教程

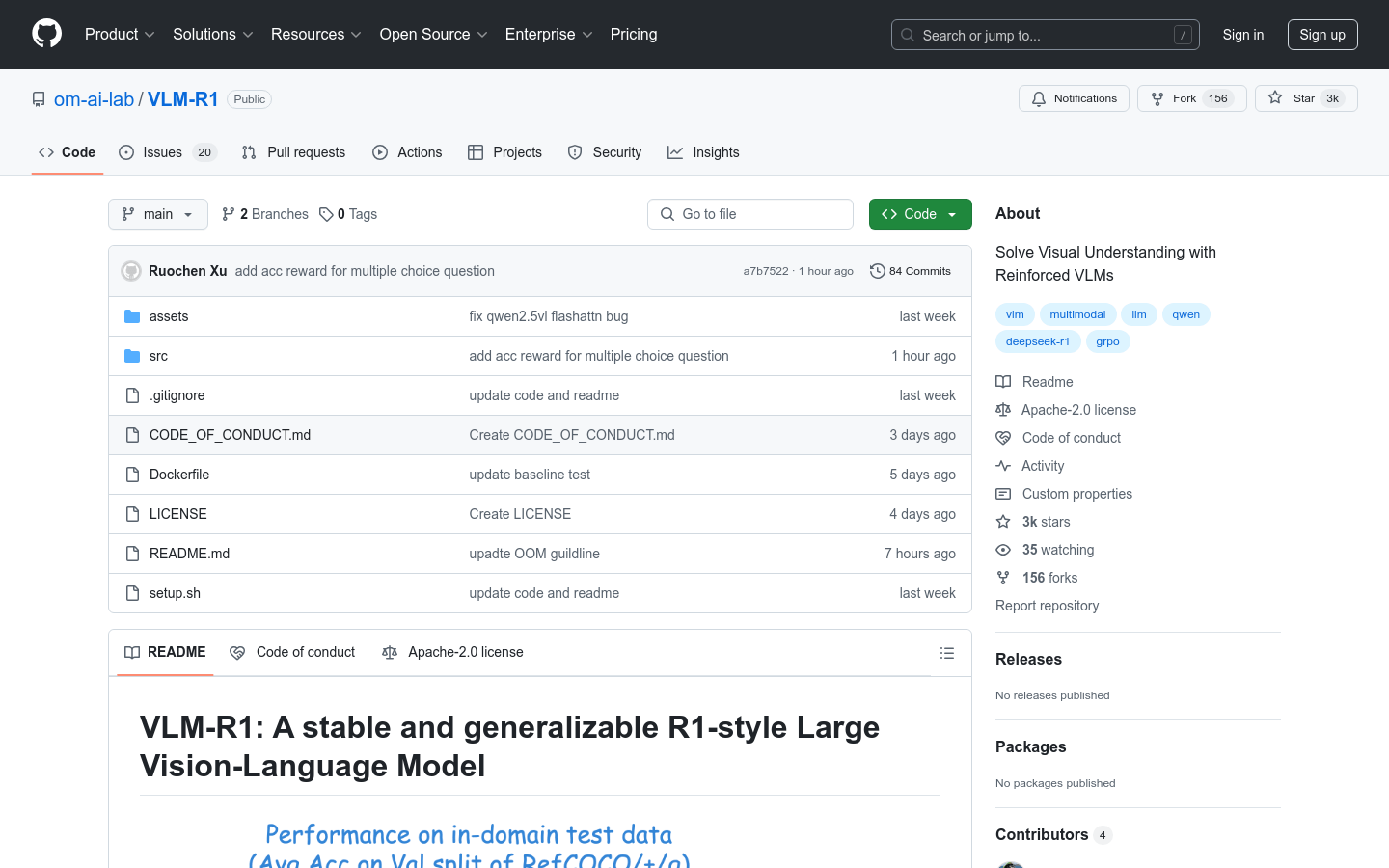

1. 克隆 VLM-R1 仓库并安装依赖:`git clone https://github.com/om-ai-lab/VLM-R1.git` 和运行 `bash setup.sh`。

2. 准备数据集,下载 COCO 图像和指代表达理解任务的标注文件。

3. 配置数据路径和模型参数,编辑 `rec.yaml` 文件以指定数据集路径。

4. 使用 GRPO 方法训练模型:运行 `bash src/open-r1-multimodal/run_grpo_rec.sh`。

5. 评估模型性能:运行 `python test_rec_r1.py` 进行模型评估。