使用场景

在自然语言处理任务中,FlashMLA 可以显著提升 Transformer 模型的推理速度。

在计算机视觉任务中,FlashMLA 可以优化卷积神经网络的内存访问效率。

在大规模推荐系统中,FlashMLA 可以加速用户行为预测模型的计算。

产品特色

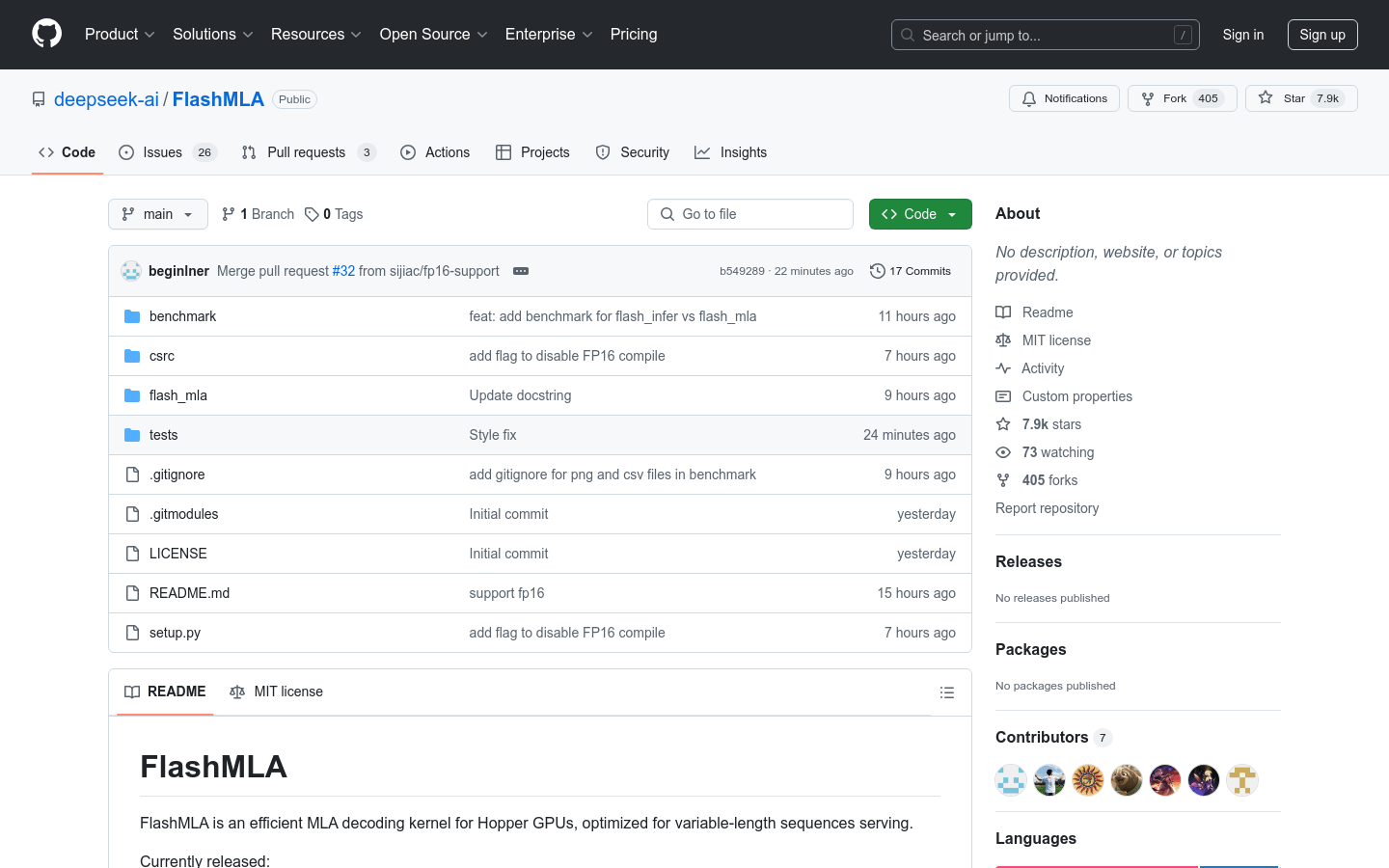

支持 BF16 数据格式,提升计算效率和精度。

提供分页 kvcache,块大小为 64,优化内存管理。

兼容 Hopper GPU 架构,充分利用硬件加速能力。

支持 CUDA 12.3 及以上版本,确保与最新技术的兼容性。

通过 PyTorch 2.0 集成,易于在现有深度学习项目中使用。

使用教程

1. 安装 FlashMLA:运行 `python setup.py install` 完成安装。

2. 运行基准测试:执行 `python tests/test_flash_mla.py` 测试性能。

3. 导入 FlashMLA 模块:在代码中导入 `flash_mla` 模块。

4. 获取元数据:调用 `get_mla_metadata` 函数获取调度元数据。

5. 使用解码内核:调用 `flash_mla_with_kvcache` 函数进行高效解码。