使用场景

在 A100 GPU 上,使用 (qk dim, v_dim) = (32,64) 配置,FlexHeadFA 显著提升了模型的推理速度。

开发者可以通过自定义头维度配置,优化模型以适应特定任务的需求。

在长序列数据处理任务中,FlexHeadFA 的内存效率优势尤为明显,能够有效降低计算成本。

产品特色

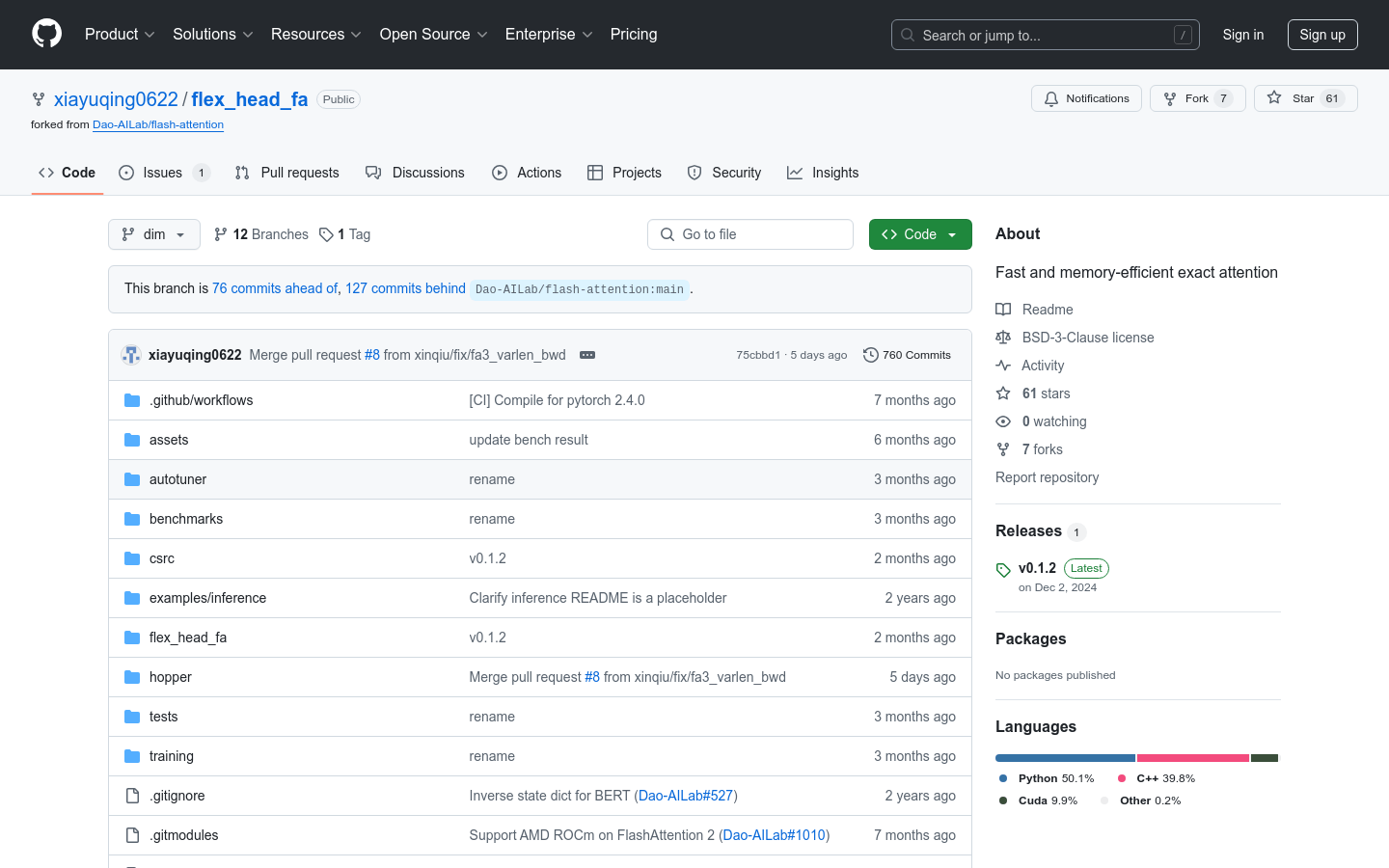

支持 FlashAttention-2 和 FlashAttention-3 的所有配置

提供灵活的头维度配置,如 QKHeadDim 和 VHeadDim 的多种组合

支持不等数量的查询头、键头和值头配置

通过自动生成实现代码,支持未预设的头维度

提供高效的前向和后向传播计算,优化内存使用

使用教程

1. 安装 FlexHeadFA:通过 pip install flex-head-fa --no-build-isolation 或从源代码编译。

2. 替换 FlashAttention:在代码中将 flash_attn 替换为 flex_head_fa。

3. 配置头维度:根据需求设置 QKHeadDim 和 VHeadDim 参数。

4. 使用模型:调用 flex_head_fa.flash_attn_func 进行前向计算。

5. 自定义实现:对于未支持的头维度,使用 autotuner 自动生成实现代码。