使用场景

在深度学习模型的训练过程中,使用DeepGEMM加速FP8格式的矩阵乘法运算,显著提升训练速度。

在推理阶段,通过DeepGEMM的分组GEMM功能,优化混合专家模型(MoE)的计算性能。

开发者可以将DeepGEMM集成到现有的深度学习框架中,利用其优化技术提升整体系统的效率。

产品特色

支持FP8格式的高效矩阵乘法,适用于深度学习中的GEMM运算

采用细粒度缩放技术,提升计算精度和性能

利用Hopper架构的TMA特性,实现快速数据传输和优化

全JIT设计,无需安装时编译,运行时动态编译优化

支持多种矩阵乘法场景,包括普通GEMM和分组GEMM

提供多种优化技术,如持久化线程专业化、FFMA指令优化等

简洁易用的API,方便开发者集成到现有项目中

使用教程

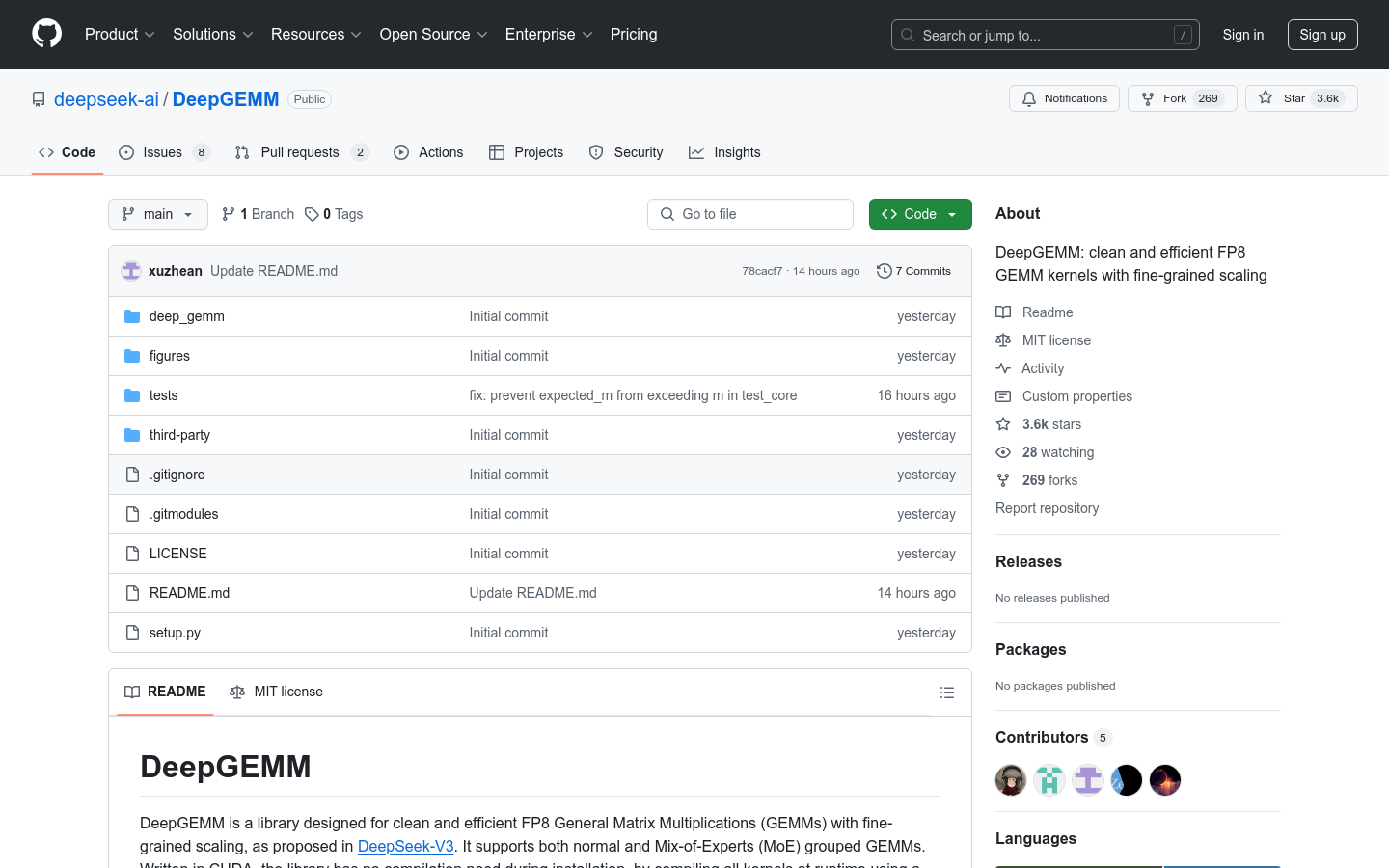

1. 克隆DeepGEMM仓库并初始化子模块:`git clone --recursive https://github.com/deepseek-ai/DeepGEMM.git`

2. 安装依赖,包括Python 3.8+、CUDA 12.3+、PyTorch 2.1+等

3. 使用`python setup.py develop`进行开发模式安装

4. 测试JIT编译和核心功能:`python tests/test_jit.py`和`python tests/test_core.py`

5. 在Python项目中导入`deep_gemm`模块并使用其提供的GEMM函数