使用场景

在大规模语言模型训练中,使用DualPipe算法显著减少了训练时间。

在计算机视觉任务中,通过优化并行策略,提高了模型的收敛速度。

在多节点分布式训练环境中,DualPipe减少了通信开销,提升了整体效率。

产品特色

实现双向流水线并行,减少计算与通信的等待时间。

优化微批次调度,提高资源利用率。

支持大规模分布式训练,适用于深度学习模型。

提供灵活的定制接口,允许用户根据需求调整并行策略。

通过减少流水线气泡,提高整体训练效率。

使用教程

1. 安装PyTorch 2.0及以上版本。

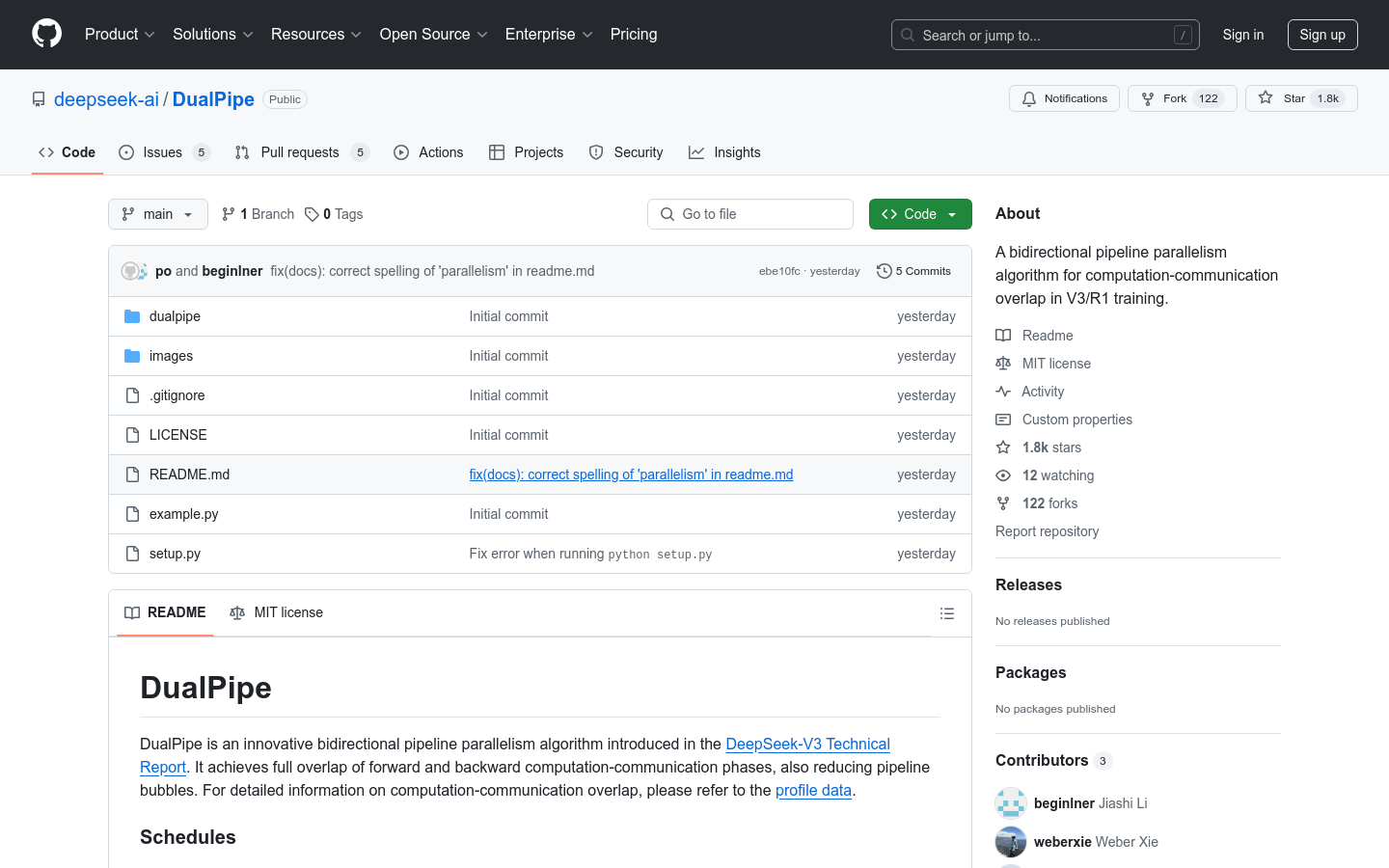

2. 克隆DualPipe仓库并安装相关依赖。

3. 根据具体任务需求,实现自定义的`overlapped_forward_backward`方法。

4. 使用`example.py`作为起点,运行并测试算法效果。

5. 根据实际需求调整并行策略和参数配置。