使用场景

在自然语言处理(NLP)任务中,使用EPLB优化Transformer模型的专家并行训练,显著提高训练速度。

在计算机视觉任务中,通过EPLB实现多GPU环境下的专家负载均衡,提升模型性能。

在大规模推荐系统中,利用EPLB优化专家并行训练过程,减少训练时间和资源消耗。

产品特色

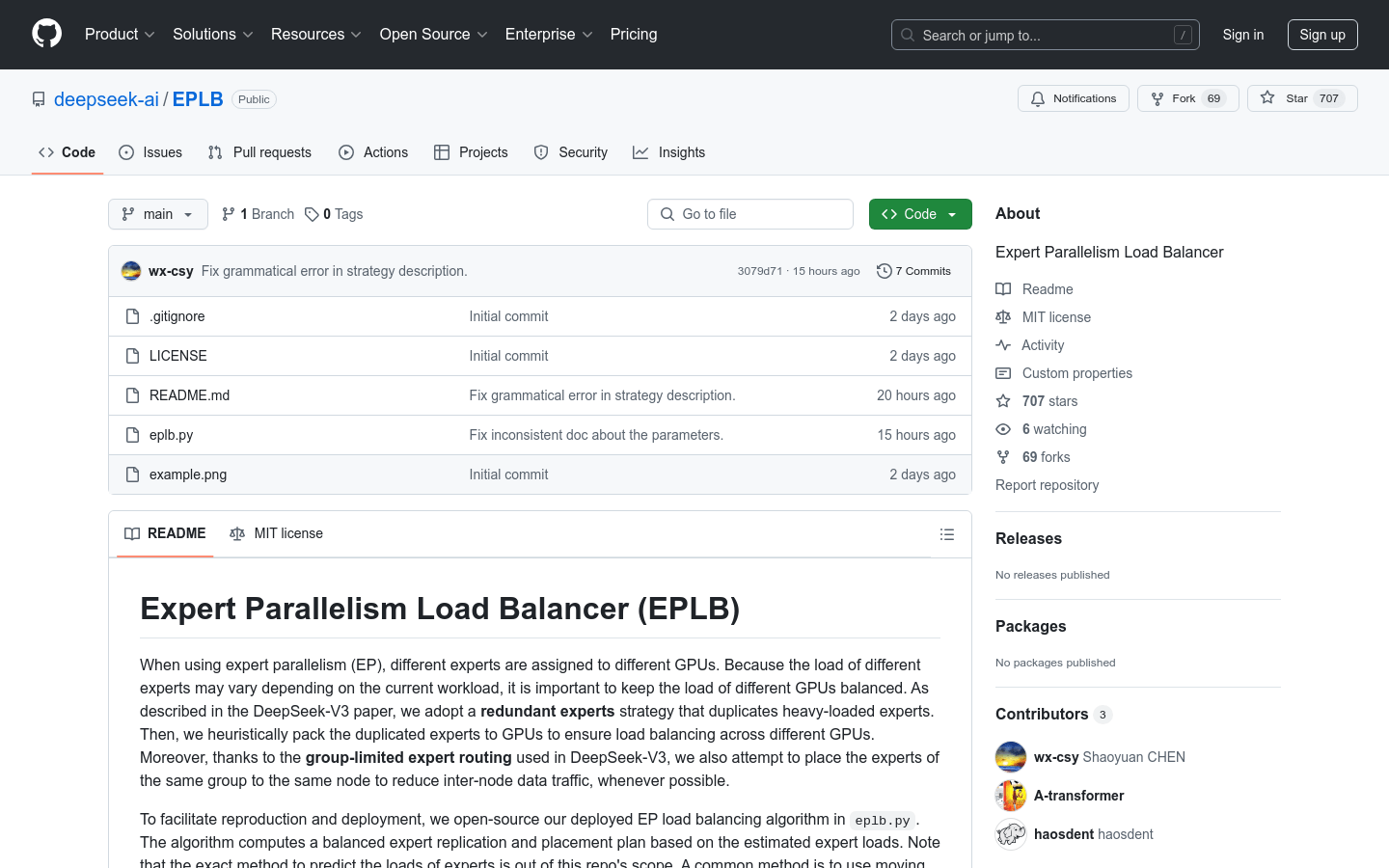

支持层次化负载均衡和全局负载均衡两种策略,适应不同阶段的训练需求。

通过冗余专家策略,动态复制负载较重的专家,确保负载平衡。

利用组限制专家路由,尽量将同一组的专家放置在同一节点上,减少跨节点通信。

提供基于估计专家负载的专家复制和放置计划,支持自定义负载预测方法。

开源实现,便于用户在不同框架中集成和扩展。

使用教程

1. 克隆EPLB仓库到本地。

2. 安装依赖库,如PyTorch等。

3. 准备专家负载数据,例如通过历史统计计算负载。

4. 调用`eplb.rebalance_experts`函数,传入负载数据和相关参数(如副本数、节点数、GPU数等)。

5. 根据输出的专家复制和放置计划,配置模型训练环境。