使用场景

在金融领域,用于分析和生成金融报告,提供准确的市场预测和投资建议。

在内容创作中,帮助生成文章、故事或创意文案,提高创作效率。

在客服场景中,作为聊天机器人回答用户问题,提供准确且自然的语言回复。

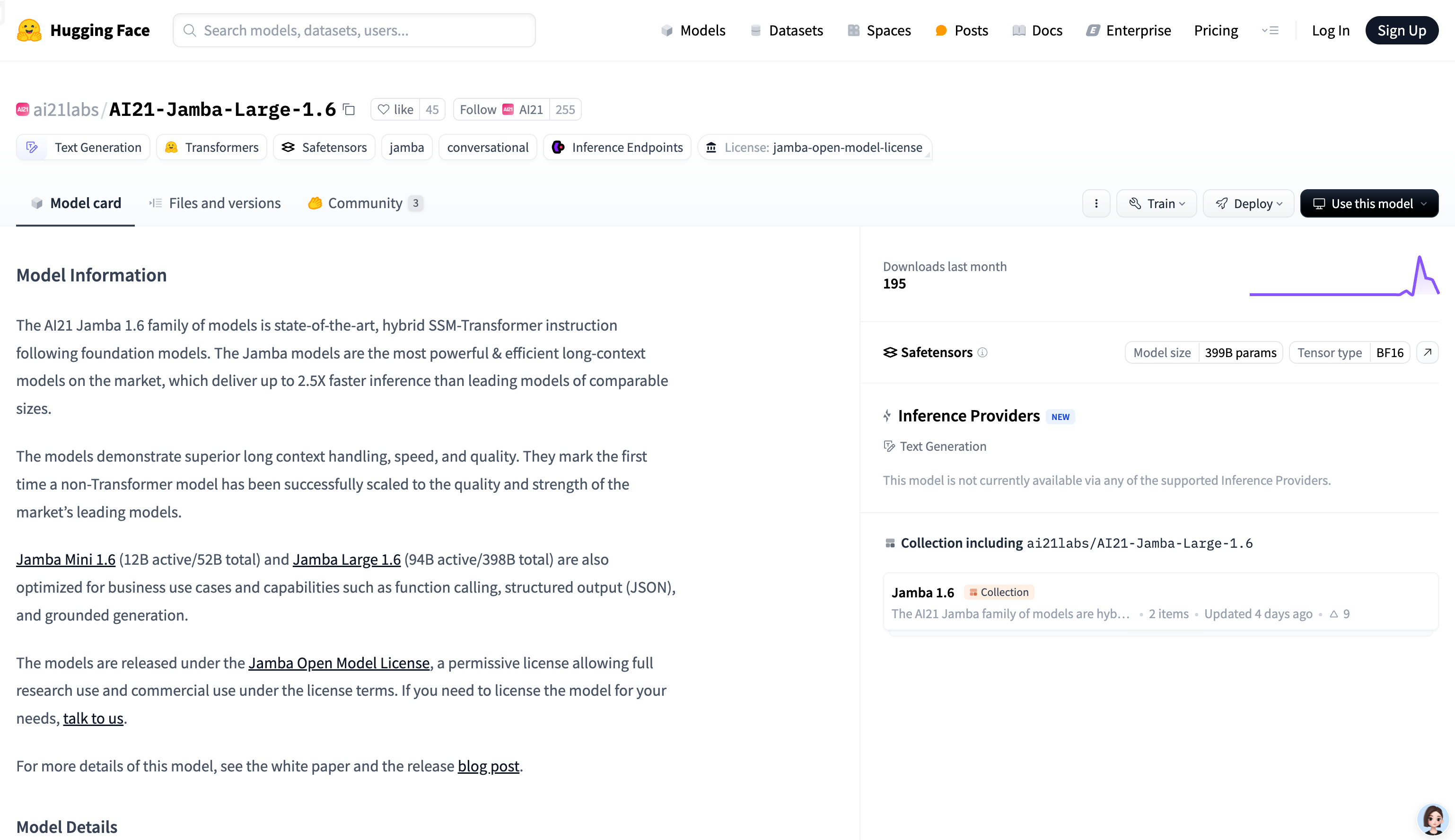

产品特色

支持长文本处理(上下文长度达 256K),适合处理长文档和复杂任务

推理速度快,比同类模型快 2.5 倍,显著提高效率

支持多种语言,包括英语、西班牙语、法语等,适用于多语言应用场景

具备指令跟随能力,能够根据用户指令生成高质量文本

支持工具调用,可与外部工具结合,扩展模型功能

使用教程

1. 安装必要的依赖,如 mamba-ssm、causal-conv1d 和 vllm(推荐使用 vllm 进行高效推理)。

2. 使用 vllm 加载模型,设置合适的量化策略(如 ExpertsInt8)以适应 GPU 资源。

3. 使用 transformers 库加载模型,结合 bitsandbytes 进行量化,以优化推理性能。

4. 准备输入数据,使用 AutoTokenizer 对文本进行编码。

5. 调用模型生成文本,通过设置参数(如温度、最大生成长度)控制生成结果。

6. 对生成的文本进行解码,提取模型输出的内容。

7. 如需使用工具调用功能,将工具定义嵌入到输入模板中,并处理模型返回的工具调用结果。