使用场景

在 GPQA Diamond 基准测试中,Steiner 在多个子领域(如量子力学、分子生物学)表现出较高的准确性,证明了其在特定学科领域的推理能力。

用户可以通过 vLLM 部署 Steiner,仅需添加特定参数即可进行推理请求,例如在对话中输入问题并获取推理结果。

Steiner 可以在没有多轮对话数据的情况下进行推理,但不推荐用于多轮对话场景,适合单轮推理任务。

产品特色

支持零样本推理,无需依赖思维链提示或代理框架。

能够在推理过程中自主探索多种路径并进行验证或回溯。

兼容现有的推理服务,推荐使用 vLLM 进行部署。

支持多语言推理,主要以英语为主,但也能处理中文。

提供详细的推理过程和结果,便于用户理解和评估。

通过强化学习优化推理路径,提高推理效率和准确性。

适用于多种学科领域的推理任务,如物理、化学、生物学等。

开源模型,允许用户在公共平台上进行测试和反馈。

使用教程

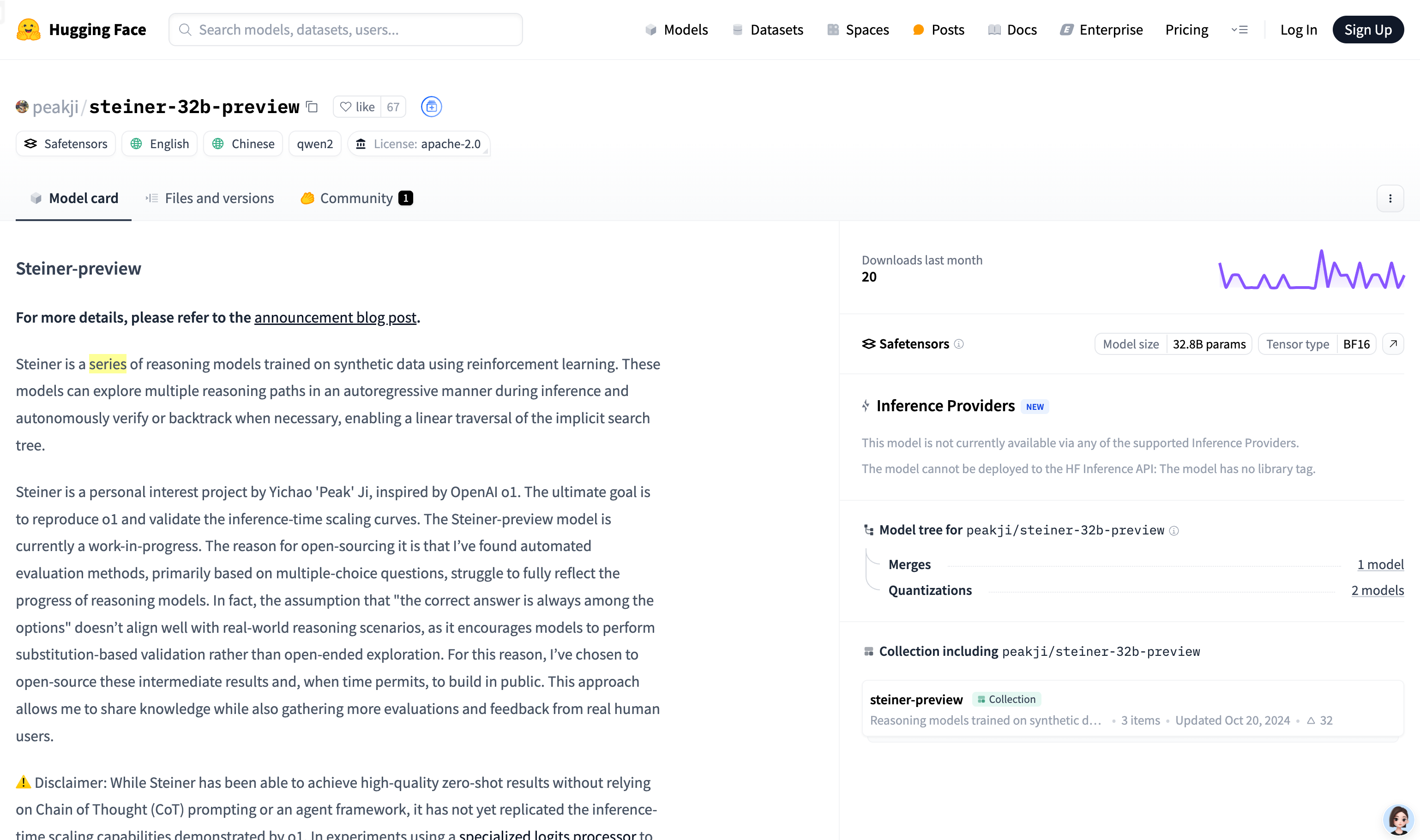

访问 Hugging Face 网站并找到 Steiner-32b-preview 模型页面。

在页面中找到部署指南,选择推荐的 vLLM 作为推理服务。

按照指南添加必要的参数(如 'skip_special_tokens': false 和 'spaces_between_special_tokens': false)到推理请求中。

使用 Python 客户端或其他支持的工具发送推理请求,例如输入问题 'Hello' 并获取模型的推理结果。

根据需要调整推理请求的格式和内容,确保模型能够正确解析和处理。

观察模型输出的推理路径和结果,评估其准确性和适用性。

根据实际需求对模型进行微调或优化,以更好地适应特定任务或领域。

将模型应用于实际场景,如学术研究、教育或开发项目中,收集反馈并持续改进。