使用场景

使用 Light-R1-7B-DS 模型在 AIME24 测试中达到 59.1% 的准确率,显著优于其他同类模型。

通过课程式 SFT 和 DPO 训练,Light-R1-32B 在 AIME24 上达到 76.6% 的准确率,超越了 DeepSeek-R1-Distill-Qwen-32B。

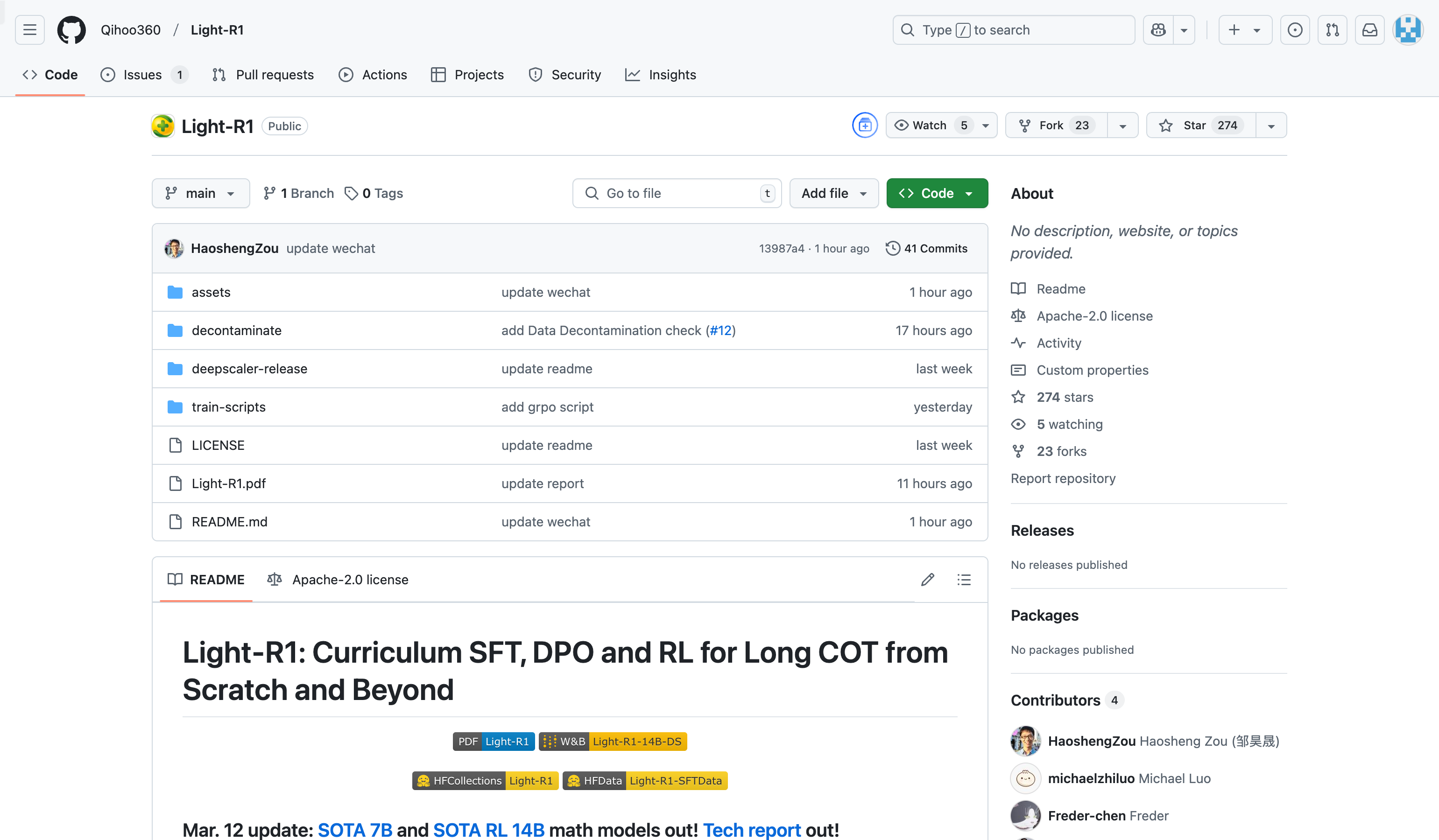

开发者可以基于开源的训练代码和数据集,快速复现 Light-R1 的训练过程,并进行定制化改进。

产品特色

提供从零开始的长链推理训练方法,无需依赖预训练的长链推理能力

开源完整的训练数据集和代码,便于研究者复现和改进

采用课程式学习,通过 SFT 和 DPO 提升模型性能

支持强化学习(RL)训练,进一步优化模型表现

在数学推理领域表现出色,特别是在 AIME24 和 AIME25 等基准测试中

使用教程

1. 克隆 Light-R1 项目代码到本地。

2. 下载并安装项目依赖的 Python 包。

3. 使用开源的训练数据集运行 SFT 训练脚本。

4. 在 SFT 基础上运行 DPO 训练脚本,进一步优化模型。

5. 使用训练好的模型进行推理或继续进行 RL 训练。