使用场景

1. 研究人员利用该模型研究不同场景下的视图合成效果,通过调整目标相机轨迹,分析模型生成的新视图在3D一致性方面的表现。

2. 一位艺术家在创作数字绘画作品时,借助Stable Virtual Camera生成的不同视角场景视图获取灵感,创作出具有独特视角的艺术作品。

3. 教师在制作关于建筑结构的教学视频时,使用该模型生成建筑不同角度的3D视图,帮助学生更直观地理解建筑结构。

产品特色

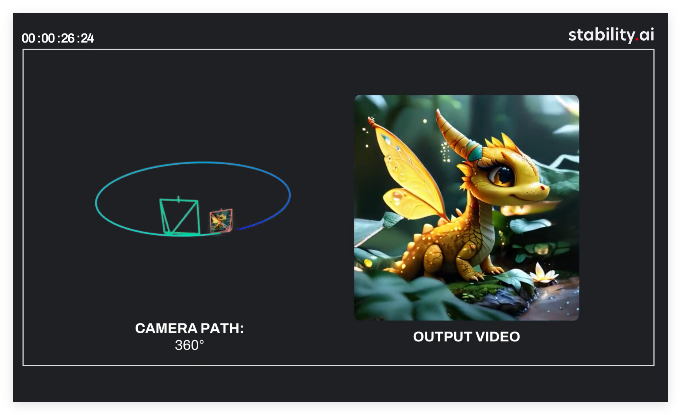

- **新型视图合成**:根据输入的多个视图和目标相机,生成3D一致的新场景视图,为场景创作提供更多视角选择。

- **自由轨迹设定**:允许用户自由指定目标相机轨迹,跨越较大空间范围,满足多样化的创作需求。

- **大视角变化生成**:可以生成大视角变化的样本,丰富了视频内容的展示效果,为观众带来新颖的视觉体验。

- **时间平滑处理**:生成的样本在时间上具有平滑性,使视频过渡自然,观看体验更佳。

- **简化合成流程**:无需额外的NeRF蒸馏就能保持高一致性,简化了视图合成的流程,提高了创作效率。

- **高质量长视频生成**:能够生成高质量、长达半分钟的视频,且具备无缝循环的特性,适用于多种创作场景。

- **艺术创作支持**:可用于艺术作品的生成,以及在设计和其他艺术创作过程中提供素材和创意灵感。

- **教育与研究助力**:为教育或创意工具提供技术支持,也有助于研究人员对重建模型进行研究,探索模型的能力边界。

使用教程

1. 访问项目的GitHub仓库,获取使用该模型的相关代码和文档。

2. 根据GitHub上的说明,准备好运行模型所需的环境,包括安装必要的依赖项。

3. 收集用于生成新视图的输入视图数据,确保数据符合模型要求的格式。

4. 根据创作需求,确定目标相机轨迹,明确想要生成的新视图的视角和运动路径。

5. 将输入视图数据和目标相机轨迹信息按照模型的输入规范进行设置。

6. 运行代码,使用模型生成新的场景视图和视频。

7. 根据生成结果进行分析和调整,若不满意可修改输入数据或相机轨迹,再次运行模型直至达到预期效果。