使用场景

在智能客服场景中,Qwen2.5-Omni 可以实时理解客户通过语音或文字提出的问题,并以自然语音和文本的形式给出准确回答。

在教育领域,该模型可以用于开发互动式学习工具,通过语音讲解和图像展示相结合的方式,帮助学生更好地理解知识。

在内容创作方面,Qwen2.5-Omni 可以根据输入的文本或图像生成相关的视频内容,为创作者提供创意灵感和素材。

产品特色

全能创新架构:采用 Thinker-Talker 架构,Thinker 模块负责处理多模态输入并生成高层语义表征及对应文本内容,Talker 模块则以流式方式接收 Thinker 输出的语义表征与文本,流畅合成离散语音单元,实现多模态输入与语音输出的无缝衔接。

实时音视频交互:支持完全实时交互,能够处理分块输入并即时输出结果,适用于实时对话、视频会议等需要即时反馈的场景。

自然流畅的语音生成:在语音生成的自然性和稳定性方面表现出色,超越了许多现有的流式和非流式替代方案,能够生成高质量的自然语音。

全模态性能优势:在同等规模的单模态模型进行基准测试时,展现出卓越的性能,特别是在音频和视频理解方面,优于类似大小的 Qwen2-Audio 和 Qwen2.5-VL-7B 等模型。

卓越的端到端语音指令跟随能力:在端到端语音指令跟随方面表现出与文本输入处理相媲美的效果,在通用知识理解和数学推理等基准测试中表现优异,能够准确理解和执行语音指令。

使用教程

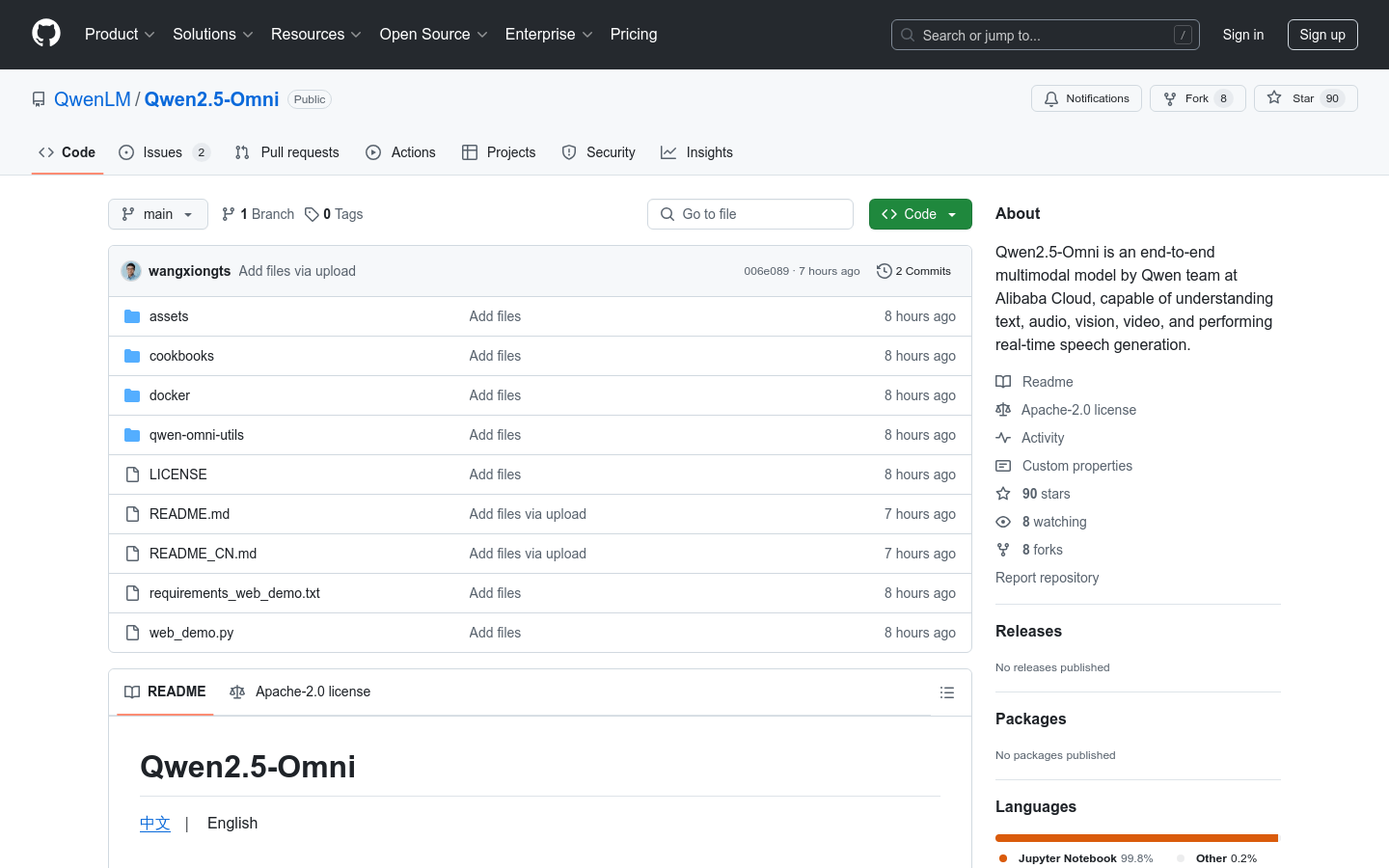

访问 Qwen Chat或 Hugging Face等平台,选择 Qwen2.5-Omni 模型。

在平台上创建一个新的会话或项目,输入需要处理的文本、上传图像、音频或视频文件。

根据需求选择模型的输出方式,如文本生成、语音合成等,并设置相关参数(如语音类型、输出格式等)。

点击运行或生成按钮,模型将实时处理输入数据并生成结果。

查看生成的文本、语音或视频结果,并根据需要进行进一步的编辑或使用。