使用场景

在语音助手中集成 Kimi-Audio,提升其对用户语音指令的理解能力。

利用 Kimi-Audio 进行音频内容的自动转录,为播客和视频内容提供字幕。

通过 Kimi-Audio 实现基于音频的情感识别,增强用户交互体验。

产品特色

多种音频处理能力:支持语音识别、音频问答、音频字幕生成等任务。

出色的性能:在多个音频基准测试上取得了 SOTA 结果。

大规模预训练:在多种类型的音频和文本数据上进行训练,增强模型的理解能力。

创新架构:采用混合音频输入和 LLM 核心,能够同时处理文本和音频输入。

高效推理:具有基于流匹配的块级流式解码器,支持低延迟音频生成。

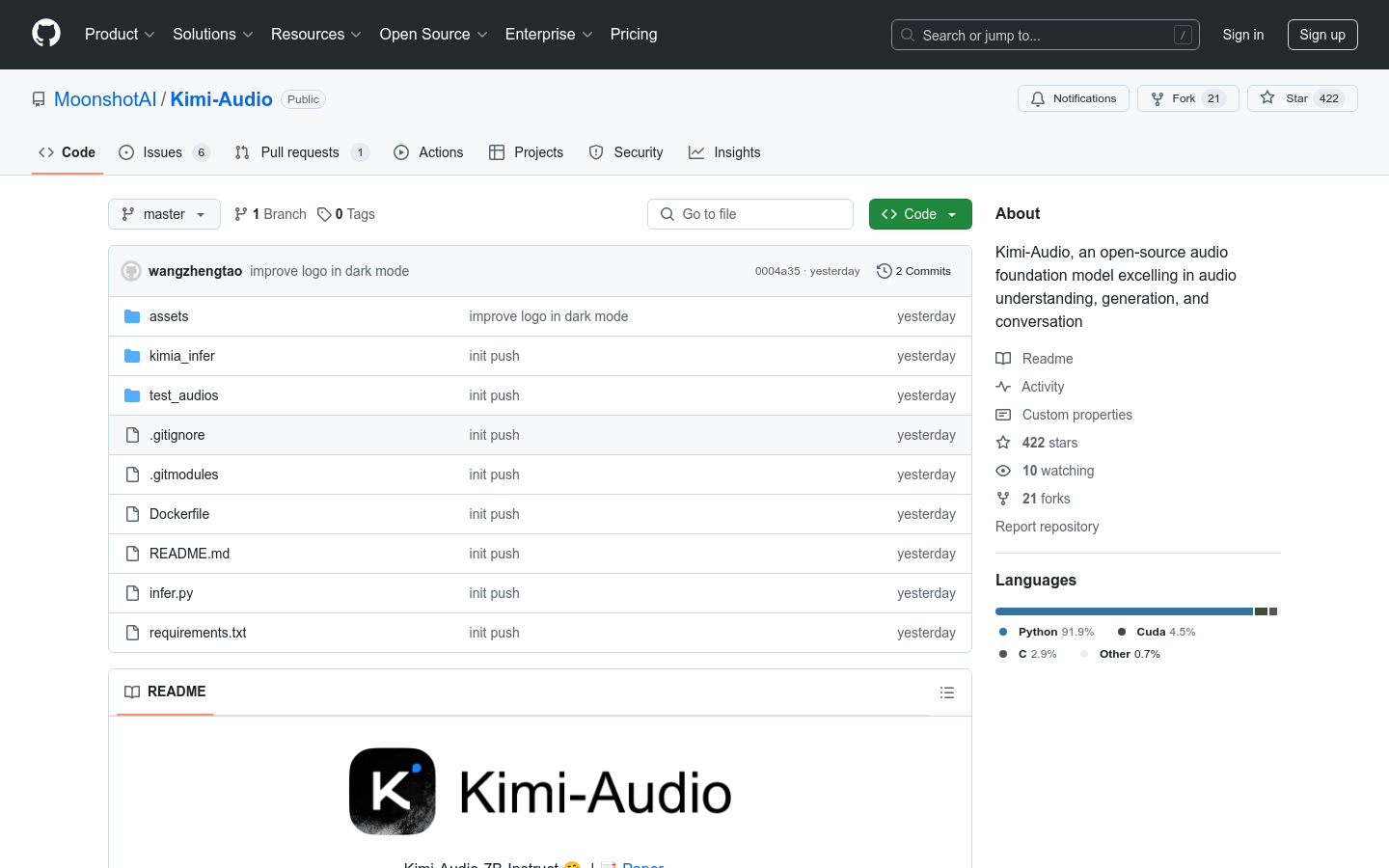

开源社区支持:提供代码、模型检查点和全面的评估工具包,推动社区研究与发展。

用户友好的接口:简化了模型的使用流程,方便用户上手。

灵活的参数设置:允许用户根据需求调整音频和文本的生成参数。

使用教程

1. 从 GitHub 页面下载 Kimi-Audio 模型和代码。

2. 安装所需的依赖库,确保环境设置正确。

3. 加载模型并设置采样参数。

4. 准备音频输入或对话信息。

5. 调用模型的生成接口,传入准备好的消息和参数。

6. 处理模型输出,获取文本或音频结果。

7. 根据需要调整参数,优化模型表现。