使用场景

使用 Agent-as-a-Judge 进行代码生成任务评估,提升开发效率。

在 AI 教学中利用此工具自动评估学生项目,提供即时反馈。

为企业内部的开发流程整合 Agent-as-a-Judge,实现高效的代码质量评估。

产品特色

自动评估:显著节省评估时间和成本。

奖励信号提供:持续反馈促进自我改进。

支持多种大语言模型(LLM)的调用。

用户友好的命令行接口,便于快速上手。

可扩展性强,适合不同的开发需求。

开源代码,支持社区贡献与改进。

整合多种评估标准,提升评估准确性。

支持与多个开发平台的兼容性。

使用教程

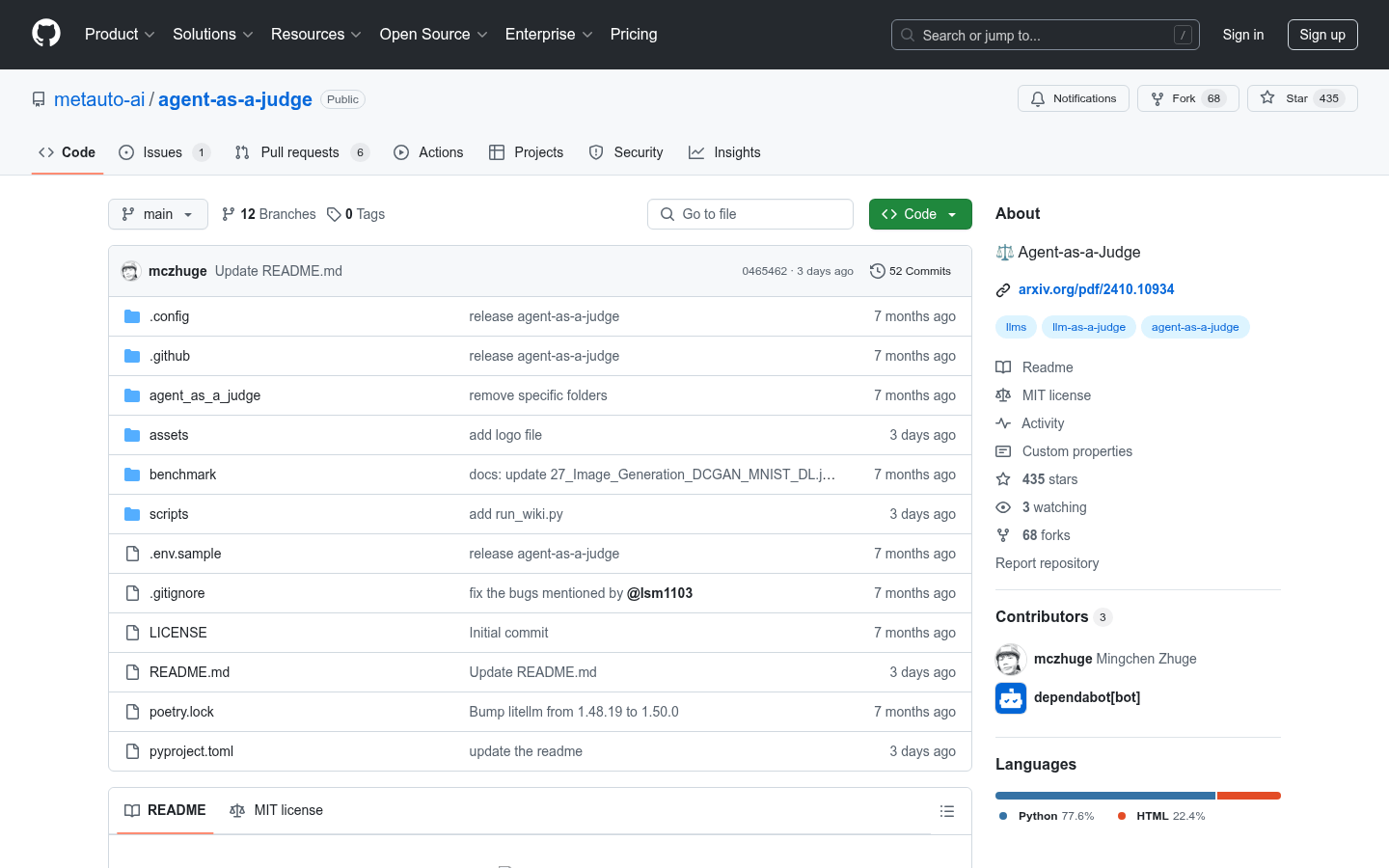

克隆代码库: git clone https://github.com/metauto-ai/agent-as-a-judge.git

创建虚拟环境并激活: conda create -n aaaj python=3.11 && conda activate aaaj

安装依赖: pip install poetry && poetry install

设置环境变量:将 .env.sample 重命名为 .env 并填写所需 API。

运行示例脚本,测试功能: PYTHONPATH=. python scripts/run_ask.py --workspace YOUR_WORKSPACE --question 'YOUR_QUESTION'