发布于AI新闻资讯发布时间 :2025年9月1号 9:09阅读 :1分钟

发布于AI新闻资讯发布时间 :2025年9月1号 9:09阅读 :1分钟近日,由中科院、北大、港科大等多所知名学术机构联合研发的 GitTaskBench 正式推出,标志着代码智能体实战交付的新标准时代的开启。

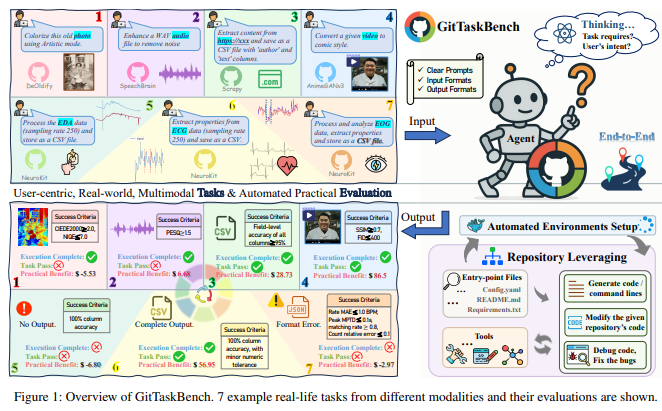

现有的评测体系往往侧重于代码生成与封闭题目,无法全面反映开发者在实际工作中遇到的诸多挑战,例如环境配置、依赖管理及跨仓库资源整合等。因此,GitTaskBench 不仅仅关注代码生成,更将整个开发流程纳入评测范围,首次实现了从仓库理解、环境配置、增量开发到项目级交付的全链路评测。

该评测工具的核心在于 “框架 × 模型” 的经济收益评估,不仅能为学术界和业界提供深刻启示,还为创业者指明了方向。其开源版本涵盖了7大模态、7个领域、24个子领域,以及54个真实任务,提供了真实的 GitHub 仓库作为测试基础。每个任务都附有详细的自然语言指令和输入输出格式,并配备任务特定的自动化评测机制,确保评测的高效性与准确性。

在 GitTaskBench 的测评框架中,整体编码能力、任务导向执行和自主环境配置三大维度被系统性分析。这一全新评测体系不仅提高了代码智能体的评估标准,也为后续研究提供了宝贵的参考。

最令人振奋的是,GitTaskBench 引入了 “性价比” 这一概念,量化了任务完成的经济效益。通过结合任务完成率、市场价值和质量系数,研究者能够更准确地评估代码智能体在不同领域的实际价值。这一创新为未来的代码智能体应用铺平了道路,显示出其在节约成本、提高效率方面的巨大潜力。

GitTaskBench 的发布将会为代码智能体的评测与应用开辟全新的局面,使其能够在实际工作中发挥更大的效用。

论文地址:https://arxiv.org/pdf/2508.18993