发布于AI新闻资讯发布时间 :2025年9月1号 9:21阅读 :1分钟

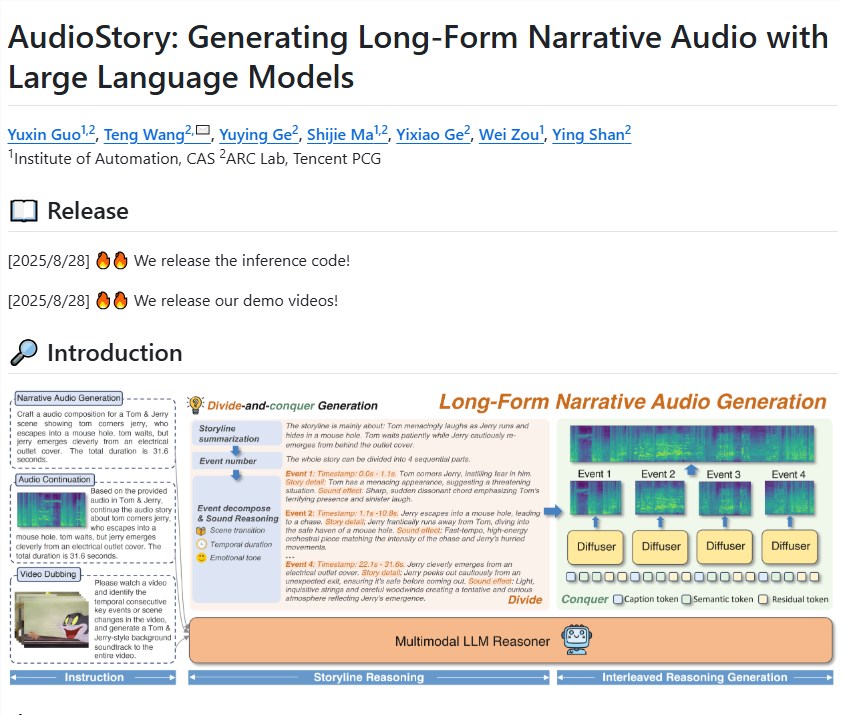

发布于AI新闻资讯发布时间 :2025年9月1号 9:21阅读 :1分钟近日,腾讯 ARC 团队发布了一款名为 AudioStory 的模型,旨在利用大语言模型(LLMs)生成长篇叙事音频。该模型解决了现有文本到音频生成技术在处理短音频方面的优势与长篇叙事音频在时间连贯性与组合推理上的挑战。

AudioStory 的核心在于其统一的理解与生成框架。该模型能够处理视频配音、音频延续和长篇叙事音频合成等多种任务。通过将大语言模型与音频生成系统结合,AudioStory 能够生成结构化且具有时间一致性的音频叙事。该模型具有强大的指令跟随推理生成能力,可以将复杂的叙事查询分解为按时间顺序排列的子任务,同时保持场景转换的连贯性和情感基调的一致性。

AudioStory 的两个显著特点包括:首先,去耦合的桥接机制,能够有效地将大语言模型与音频生成器之间的协作分成两个专业化的部分;其次,端到端的训练方式,统一指令理解与音频生成,提升了组件之间的协同效应。

此外,研究团队还建立了一个名为 AudioStory-10K 的基准数据集,涵盖动画音景和自然声音叙事等多样化领域。通过大量实验,AudioStory 在单音频生成和叙事音频生成方面的表现优于以往的文本到音频生成模型,展现出卓越的指令跟随能力和音频质量。

目前,团队已经发布了模型的推理代码,并展示了一系列演示视频,包括经典动画《猫和老鼠》的配音示例,以及基于文本生成长音频的应用案例,展示了该模型的广泛适用性和强大功能。

项目:https://github.com/TencentARC/AudioStory

划重点:

🎧 **AudioStory 是腾讯 ARC 推出的长篇叙事音频生成模型,结合了大语言模型和音频生成技术。**

📊 ** 模型具有强大的指令跟随能力,能够生成连贯的音频叙事,提升用户体验。**

🛠️ ** 团队已发布推理代码,并展示多个应用案例,展现其在视频配音和长音频生成上的优势。**