发布于AI新闻资讯发布时间 :2025年9月3号 11:01阅读 :1分钟

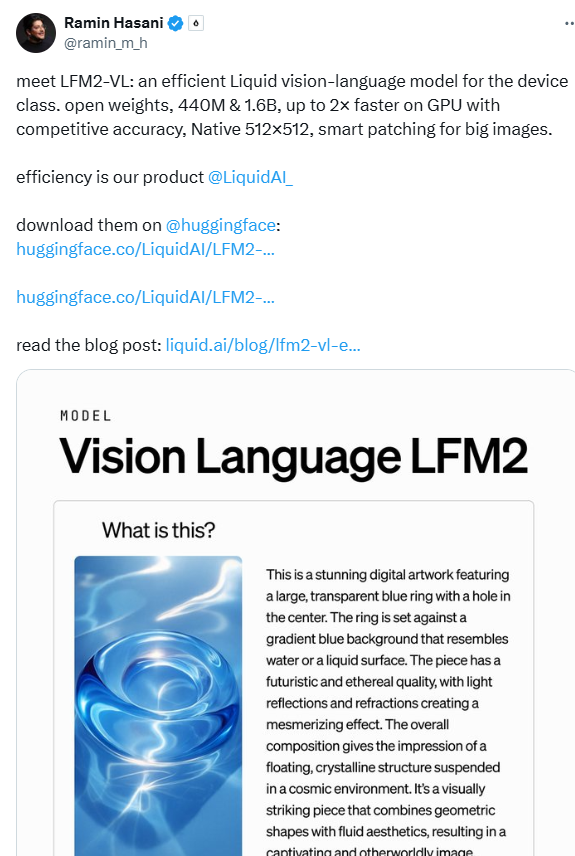

发布于AI新闻资讯发布时间 :2025年9月3号 11:01阅读 :1分钟Liquid AI 最新发布了 LFM2-VL 系列视觉语言基础模型(Vision-Language Foundation Models),这标志着多模态 AI 正朝着「精简、快速、可部署在设备端」的方向加速发展。

这两款型号分别是 LFM2-VL-450M 和 LFM2-VL-1.6B,前者专为资源受限的硬件环境设计,参数量不足5亿;后者虽参数更多但依旧轻量,适合单个 GPU 或设备直接部署。

LFM2-VL 扩展自 Liquid AI 之前推出的 LFM2架构,整合了视觉与语言处理能力,支持多分辨率的图片输入,可处理文本与图像,具有极佳的灵活性与兼容性 (liquid.ai, Venturebeat)。模型在 GPU 推理速度上实现了高达「两倍」的提升,并且在常见性能评测中表现不凡 (Venturebeat, liquid.ai)。

在图像处理方面,LFM2-VL 能以原始分辨率(最高512×512)输入图像,避免因强制缩放带来的失真问题。对于更大尺寸图像,模型会采用非重叠切片方式处理,并配合缩略图以获取全局语境信息 (Venturebeat, liquid.ai)。其架构由语言模型主干、SigLIP2NaFlex 视觉编码器与一个多模态投影器构成。投影器使用两层 MLP(带 pixel unshuffle 技术)来减少图像 token 数量,从而提升处理速度 (Venturebeat, liquid.ai)。

训练数据方面,LFM2-VL 涉及约1,000亿多模态训练 token,来源包括开源数据集与公司自有合成图像数据 (Venturebeat, liquid.ai)。评测结果显示,LFM2-VL-1.6B 在 RealWorldQA(65.23)、InfoVQA(58.68)、OCRBench(742)等任务中成绩优异,同时在推理效率上领先于同类模型 (Venturebeat, liquid.ai)。

目前,这些模型已在 Hugging Face 发布,并附有在 Colab 上的微调示例代码,兼容 Hugging Face Transformers 与 TRL 库。它们采用了一种基于 Apache2.0原则的新“LFM1.0授权协议”,允许学术使用,年收入低于1,000万美元的公司可用于商业,而年营收更高的企业则需联系 Liquid AI 获取授权 (Venturebeat, liquid.ai)。

Liquid AI 的 LFM2-VL 模型组合为视觉与文本融合 AI 在设备端部署提供了新的路径,尤其适合手机、笔记本、可穿戴设备等场景,有助于降低对云端依赖,提升隐私与响应速度。

项目:https://huggingface.co/LiquidAI/LFM2-VL-1.6B

划重点:

🆕 两种型号设计:LFM2-VL-450M(极简资源环境适用)和 LFM2-VL-1.6B(更强但依然轻量),适配设备端部署。

速度与效率兼顾:GPU 推理速度高达2倍提升,同时具备优秀的多模态任务表现。

多平台友好环境:已发布在 Hugging Face,提供授权选项,兼容主流开发工具,适合学术与中小企业商业用途。