使用场景

用于生成训练数据,帮助开发者训练定制化的对话系统。

在数学问题解答领域,提供准确的逻辑推理和解答生成。

辅助编程人员快速理解代码逻辑,提供编程指导和代码生成。

产品特色

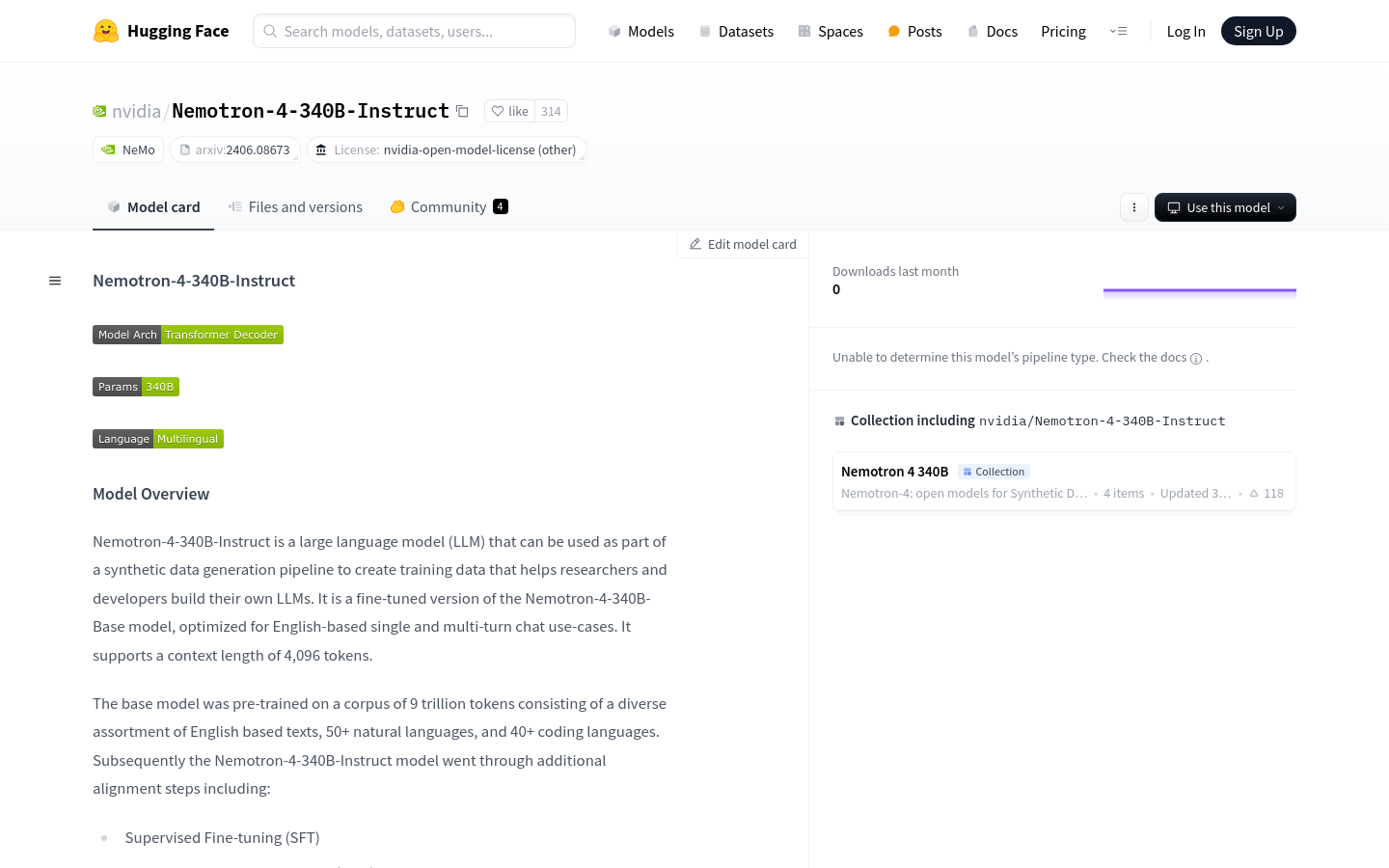

支持4096个token的上下文长度,适用于长文本处理。

经过SFT、DPO和RPO等对齐步骤,优化了对话和指令遵循能力。

能够生成高质量的合成数据,助力开发者构建自己的LLM。

使用了Grouped-Query Attention (GQA)和Rotary Position Embeddings (RoPE)技术。

支持NeMo Framework的定制工具,包括参数高效微调和模型对齐。

在多种评估基准上表现优异,如MT-Bench、IFEval、MMLU等。

使用教程

1. 使用NeMo Framework创建一个Python脚本与部署的模型进行交互。

2. 创建一个Bash脚本来启动推理服务器。

3. 使用Slurm作业调度系统将模型分布在多个节点上,并与推理服务器关联。

4. 定义Python脚本中的文本生成函数,设置请求头和数据结构。

5. 调用文本生成函数,传入提示(prompt)和生成参数,获取模型响应。

6. 根据需要调整生成参数,如温度(temperature)、top_k、top_p等,以控制文本生成的风格和多样性。

7. 通过调整系统提示(system prompt)来优化模型的输出,以达到更好的对话效果。