使用场景

- 作为语音代理,处理用户的语音指令。

- 进行语音到语音的翻译,帮助跨语言沟通。

- 分析语音音频,提取关键信息,用于安全监控或客户服务。

产品特色

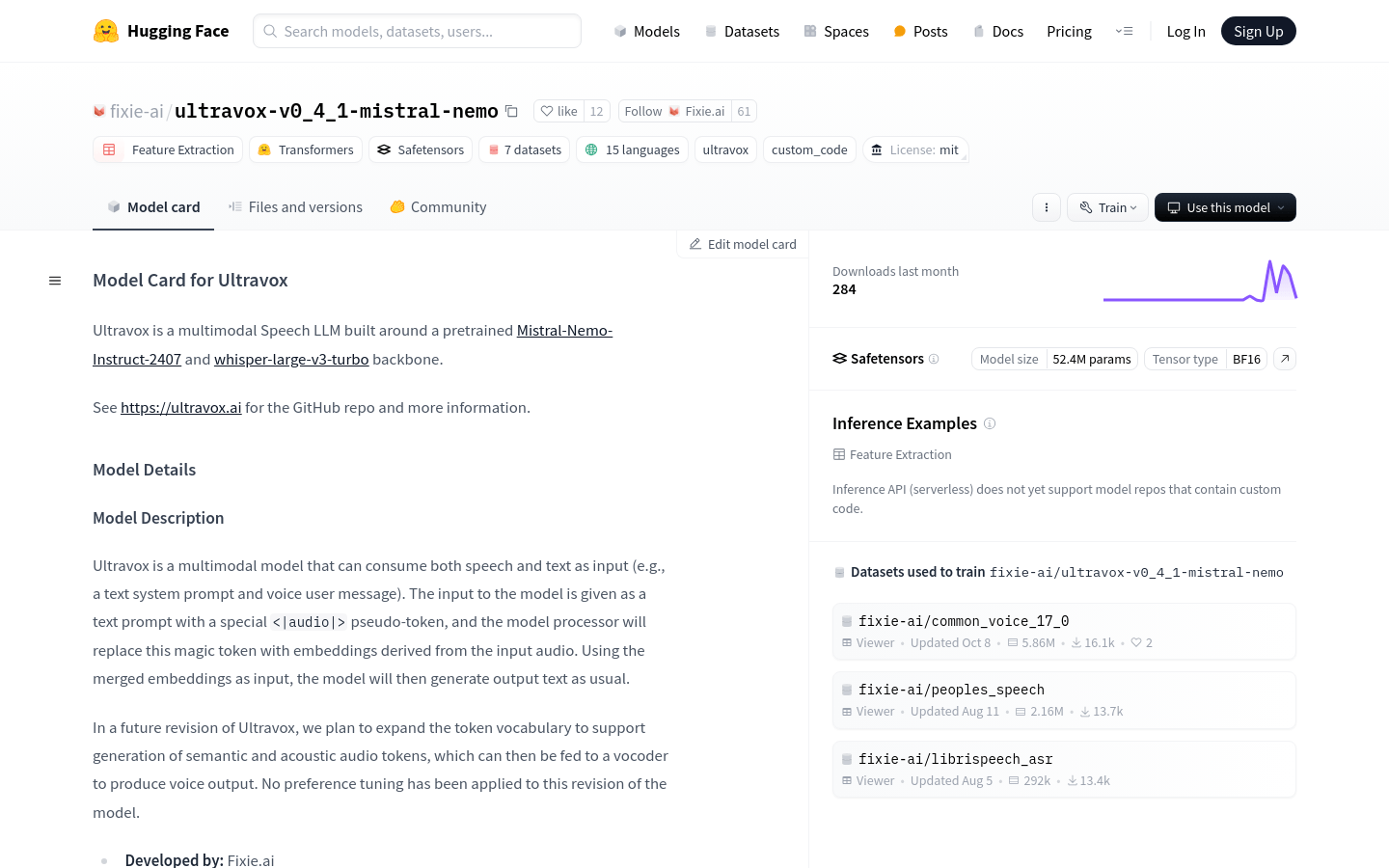

- 语音和文本输入处理:能够同时处理语音和文本输入,适用于多种应用场景。

- 音频嵌入替换:使用<|audio|>伪标记将输入音频转换为嵌入,提高模型的多模态处理能力。

- 语音到语音翻译:适用于语音翻译,分析语音音频等场景。

- 模型生成文本:基于合并的嵌入输入生成输出文本。

- 未来支持语义和声学音频标记:计划在未来版本中支持生成语义和声学音频标记,进一步扩展模型功能。

- 知识蒸馏损失训练:使用知识蒸馏损失进行训练,使Ultravox模型尝试匹配基于文本的Mistral骨干的logits。

- 混合精度训练:采用BF16混合精度训练,提高训练效率。

使用教程

1. 安装必要的库:使用pip安装transformers、peft和librosa库。

2. 导入库:在代码中导入transformers、numpy和librosa库。

3. 加载模型:使用transformers.pipeline加载'fixie-ai/ultravox-v0_4_1-mistral-nemo'模型。

4. 准备音频输入:使用librosa.load加载音频文件,并获取音频数据和采样率。

5. 定义对话轮次:创建一个包含系统角色和内容的对话轮次列表。

6. 调用模型:将音频数据、对话轮次和采样率作为参数,调用模型生成输出文本。

7. 获取结果:模型将生成的文本作为输出,可以用于进一步的处理或显示。