使用场景

在图像描述任务中,使用POINTS-Yi-1.5-9B-Chat生成详细的图像描述。

在视觉问答任务中,利用模型回答与图像相关的问题。

在视觉指令执行任务中,根据用户提供的图像和指令,模型执行相应的操作。

产品特色

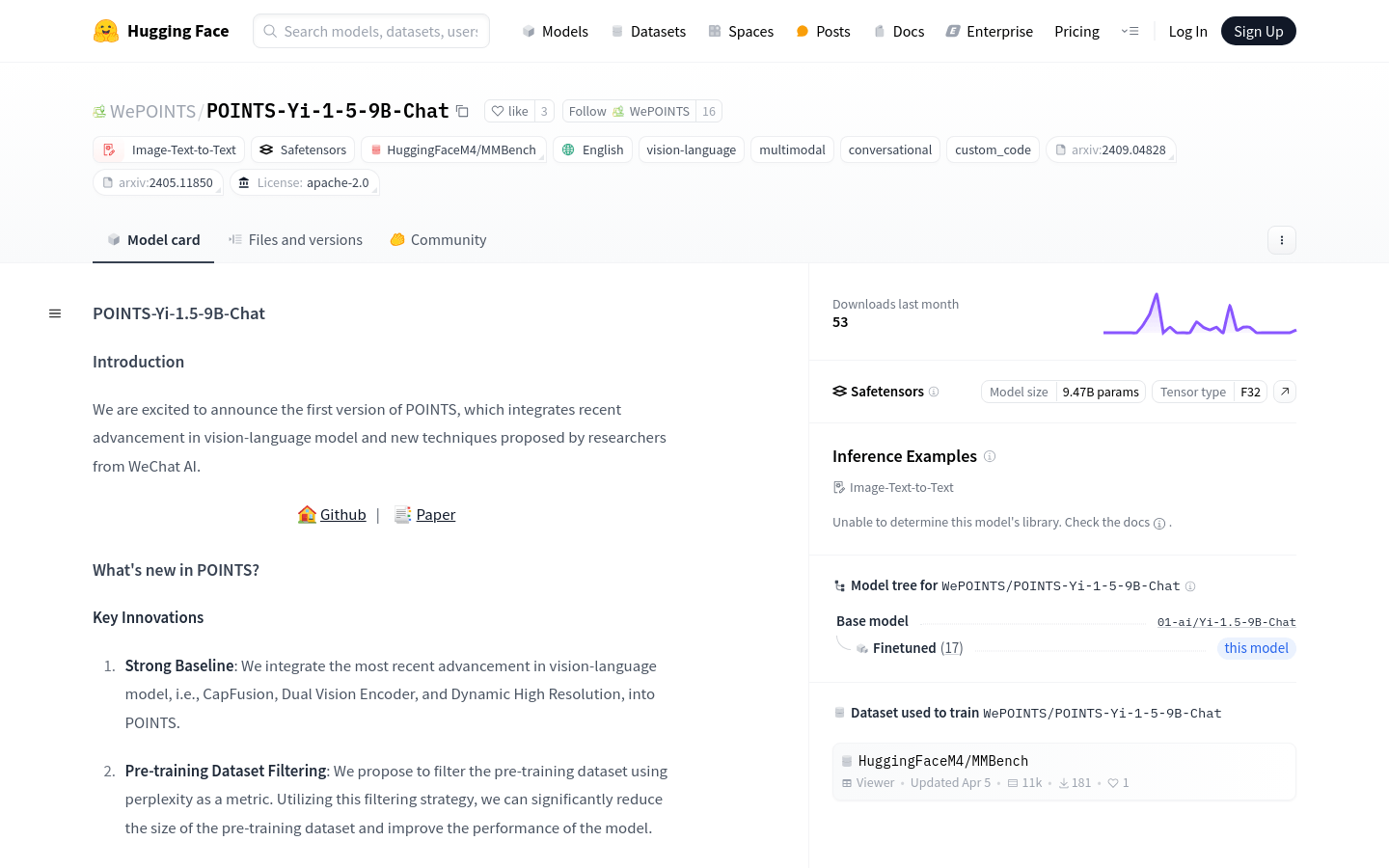

集成最新的视觉语言模型技术,如CapFusion、Dual Vision Encoder和Dynamic High Resolution。

使用困惑度作为指标过滤预训练数据集,减少数据集大小并提高模型性能。

应用模型汤技术,对不同视觉指令调整数据集微调后的模型进行整合,进一步提升性能。

在多个基准测试中表现优异,包括MMBench-dev-en、MathVista、HallucinationBench等。

支持Image-Text-to-Text的多模态交互,适用于需要视觉和语言结合的场景。

提供了详细的使用示例和代码,方便开发者快速上手和集成。

使用教程

1. 安装必要的库,如transformers、PIL和torch。

2. 导入AutoModelForCausalLM和AutoTokenizer,以及CLIPImageProcessor。

3. 准备图像数据,可以是网络图片或本地。图片。

4. 加载模型和分词器,指定模型路径为'WePOINTS/POINTS-Yi-1-5-9B-Chat'。

5. 配置生成参数,如最大新令牌数、温度、top_p和beam数。

6. 使用模型的chat方法,传入图像、提示、分词器、图像处理器等参数。

7. 获取模型输出并打印结果。