使用场景

在自然语言处理任务中,用于生成高质量的代码和逻辑推理结果。

作为研究工具,探索循环深度模型在不同任务中的性能和效率。

在资源受限的设备上,通过动态调整计算量实现高效的推理。

产品特色

支持在测试时动态调整模型深度,根据任务需求灵活配置计算量。

具备强大的推理和代码生成能力,适用于复杂的逻辑任务。

提供多种高级特性,如每token自适应计算、KV缓存共享和连续推理。

支持bfloat16混合精度推理,优化计算性能和资源消耗。

提供详细的使用指南和代码示例,方便开发者快速上手。

使用教程

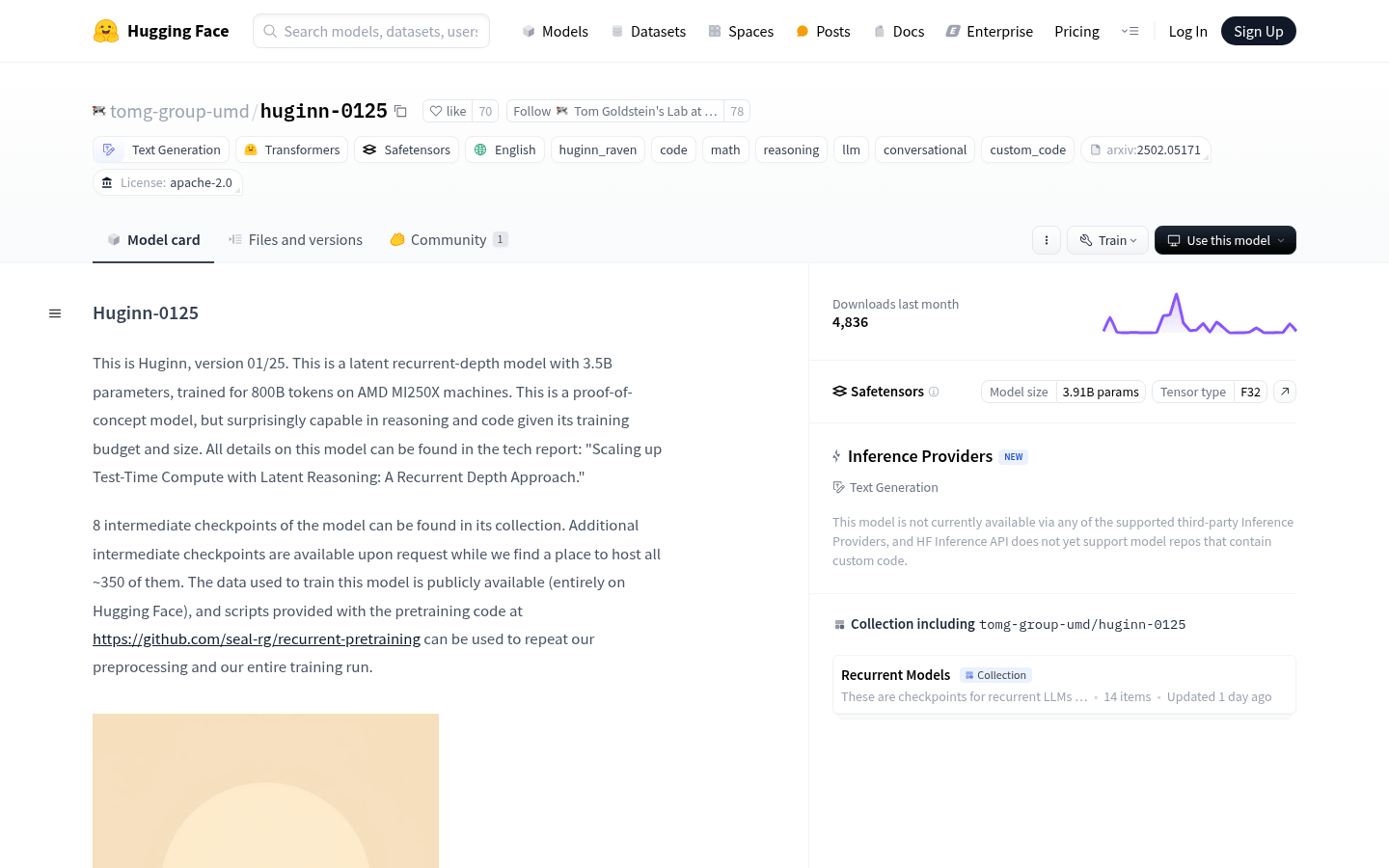

1. 使用Hugging Face平台下载模型:通过`transformers`库加载模型和分词器。

2. 配置模型参数:根据需要设置`num_steps`参数以调整模型深度。

3. 进行推理:使用`bfloat16`精度运行模型,调用`generate`方法生成文本。

4. 使用高级特性:如自适应计算、KV缓存共享等,通过特定参数启用。

5. 优化性能:根据任务需求调整模型参数和缓存策略,以达到最佳性能。