使用场景

在多图像场景中,用户可以通过自然语言指令让模型定位特定物体或区域,例如在一组图片中找到共同出现的人物。

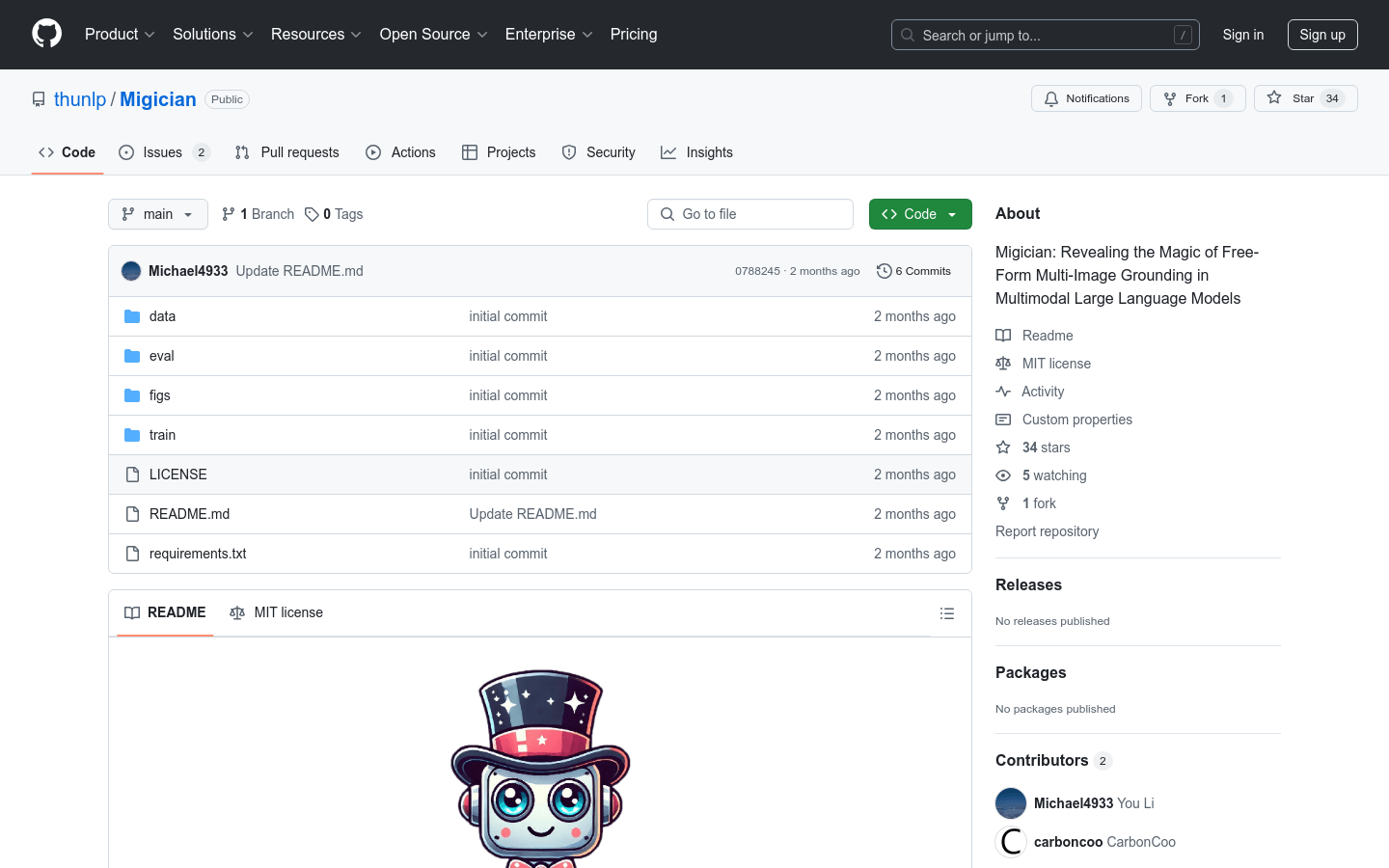

研究人员可以使用 Migician 的模型和数据集进行多图像定位任务的研究,探索新的算法和应用场景。

开发者可以将 Migician 集成到自己的应用程序中,为用户提供基于多图像定位的功能,如图像标注、目标追踪等。

产品特色

自由形式的多图像定位:支持用户通过自然语言指令进行多图像场景下的精确目标定位。

多任务支持:涵盖常见物体定位、图像差异定位、自由形式定位等多种多图像任务。

大规模数据集支持:提供 MGrounding-630k 数据集,包含 63 万条多图像定位任务数据。

高性能:在 MIG-Bench 基准测试中,性能显著优于现有的多模态大语言模型。

灵活的推理能力:支持多种推理方式,包括直接推理和基于单图像定位的链式推理。

使用教程

1. 创建 Python 环境并安装依赖:使用 `conda env create -n migician python=3.10` 创建环境,然后运行 `pip install -r requirements.txt` 安装依赖。

2. 下载数据集:从 Hugging Face 下载 MGrounding-630k 数据集,解压到指定目录。

3. 加载模型:使用 `transformers` 库加载预训练的 Migician 模型。

4. 准备输入数据:将多图像数据和自然语言指令格式化为模型所需的输入格式。

5. 运行推理:调用模型的 `generate` 方法进行推理,获取定位结果。

6. 评估性能:使用 MIG-Bench 基准测试评估模型性能,获取 IoU 等指标。