使用场景

开发者使用Qwen2.5-Coder-7B-Instruct生成一个快速排序算法的代码。

软件工程师利用模型修复现有代码库中的bug。

数据科学家使用模型生成数据处理和分析的代码。

产品特色

代码生成:显著提升代码生成能力,支持多种编程语言。

代码推理:增强代码理解能力,帮助开发者推理代码逻辑。

代码修复:自动检测并修复代码中的错误。

长上下文支持:支持长达128K令牌的长上下文,适合处理大型代码库。

基于Transformers架构:使用RoPE、SwiGLU、RMSNorm和Attention QKV偏置等先进技术。

参数数量:拥有7.61B个参数,非嵌入参数为6.53B。

层数和注意力头:具有28层和28个Q的注意力头以及4个KV的注意力头。

适用于实际应用:不仅增强编码能力,还保持在数学和通用能力方面的优势。

使用教程

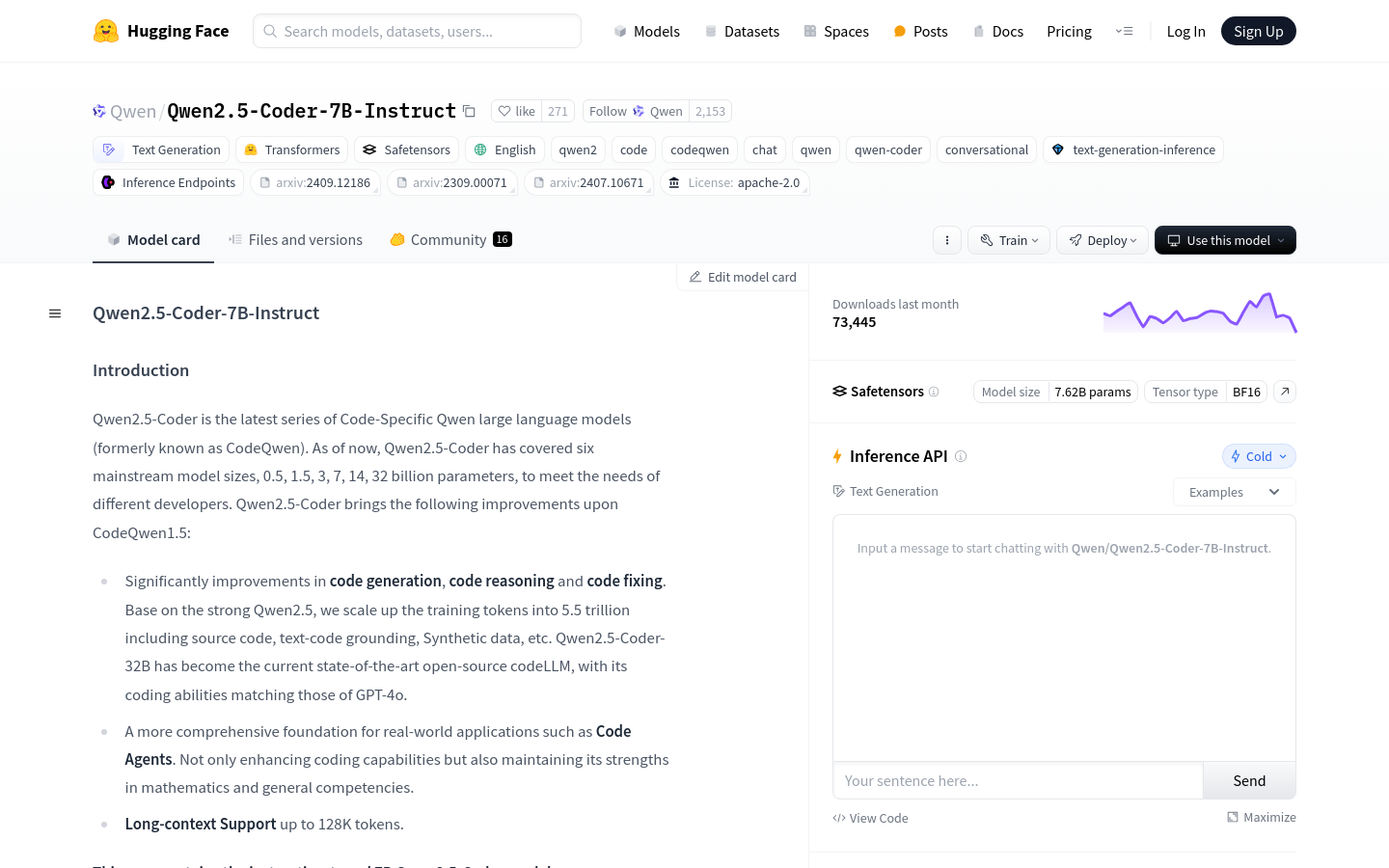

1. 访问Hugging Face平台并找到Qwen2.5-Coder-7B-Instruct模型。

2. 根据页面提供的代码片段,导入AutoModelForCausalLM和AutoTokenizer。

3. 使用模型名称加载模型和分词器。

4. 准备输入提示,例如编写一个特定功能的代码请求。

5. 将提示转换为模型可以理解的格式,使用tokenizer处理。

6. 将处理后的输入传递给模型,并设置生成参数,如最大新令牌数。

7. 模型生成响应后,使用tokenizer解码生成的令牌以获取最终结果。

8. 根据需要调整生成参数,以优化代码生成的效果。