使用场景

案例一:在监控视频中,使用该模型可以识别并分割出被遮挡的行人或车辆,提高监控系统的安全性。

案例二:在电影后期制作中,该模型可以用来修复或补全因拍摄角度问题而被遮挡的场景部分。

案例三:在自动驾驶领域,该模型能够帮助系统更好地理解复杂交通场景中的遮挡物体,提高驾驶安全性。

产品特色

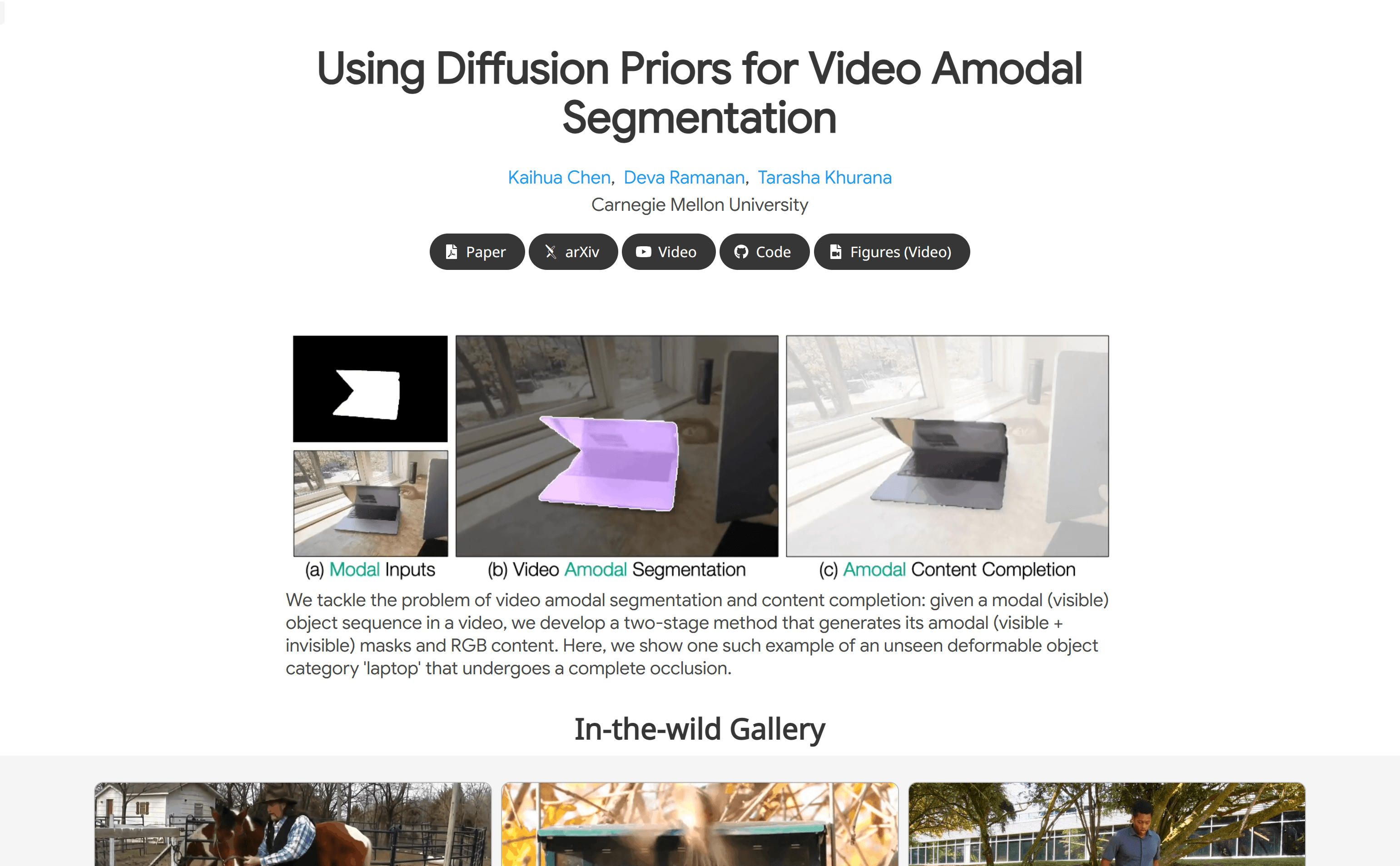

• 视频非可见物体分割:能够识别并分割视频中被遮挡的物体部分。

• 内容补全:对被遮挡的物体区域进行内容填充,恢复物体的完整外观。

• 条件生成任务:利用视频生成模型,根据可见物体序列和上下文伪深度图生成非可见物体掩码。

• 3D UNet骨干网络:模型的两个阶段都采用3D UNet骨干网络,提高了分割和补全的准确性。

• 多数据集测试:在四个不同的数据集上进行了基准测试,显示出显著的性能提升。

• 零样本学习:即使在仅在合成数据上训练的情况下,模型也能很好地泛化到真实世界场景。

• 无需额外输入:模型在不依赖相机姿态或光流等额外输入的情况下,保持了鲁棒性。

使用教程

1. 准备视频数据:确保视频数据质量良好,且包含需要分割和补全的物体。

2. 运行模型:将视频数据输入到模型中,模型将自动处理并生成非可见物体掩码。

3. 内容补全:使用模型的第二阶段对被遮挡区域进行内容补全。

4. 结果评估:对比模型输出的非可见物体掩码和实际的物体掩码,评估分割的准确性。

5. 应用场景:根据实际应用场景,将模型的输出应用到相应的系统中,如监控、电影后期制作或自动驾驶。

6. 性能优化:根据实际使用反馈,对模型进行调整和优化,以适应不同的视频内容和场景。